必要条件をインストールする

autotrain-advanced と wandb をインストールします。

- Command Line

- Notebook

pass@1 での最先端の結果を達成します。

データセットを準備する

Hugging Face AutoTrain は、独自の CSV データセットが適切に動作するために特定の形式を持つことを期待しています。-

トレーニングファイルには、トレーニングで使用される

textカラムが含まれている必要があります。最良の結果を得るために、textカラムのデータは### Human: Question?### Assistant: Answer.形式に準拠している必要があります。timdettmers/openassistant-guanacoに優れた例を確認してください。 しかし、MetaMathQA データセット には、query、response、typeのカラムが含まれています。まず、このデータセットを前処理します。typeカラムを削除し、queryとresponseカラムの内容を### Human: Query?### Assistant: Response.形式で新しいtextカラムに結合します。トレーニングは、結果のデータセット、rishiraj/guanaco-style-metamathを使用します。

autotrain を使用したトレーニング

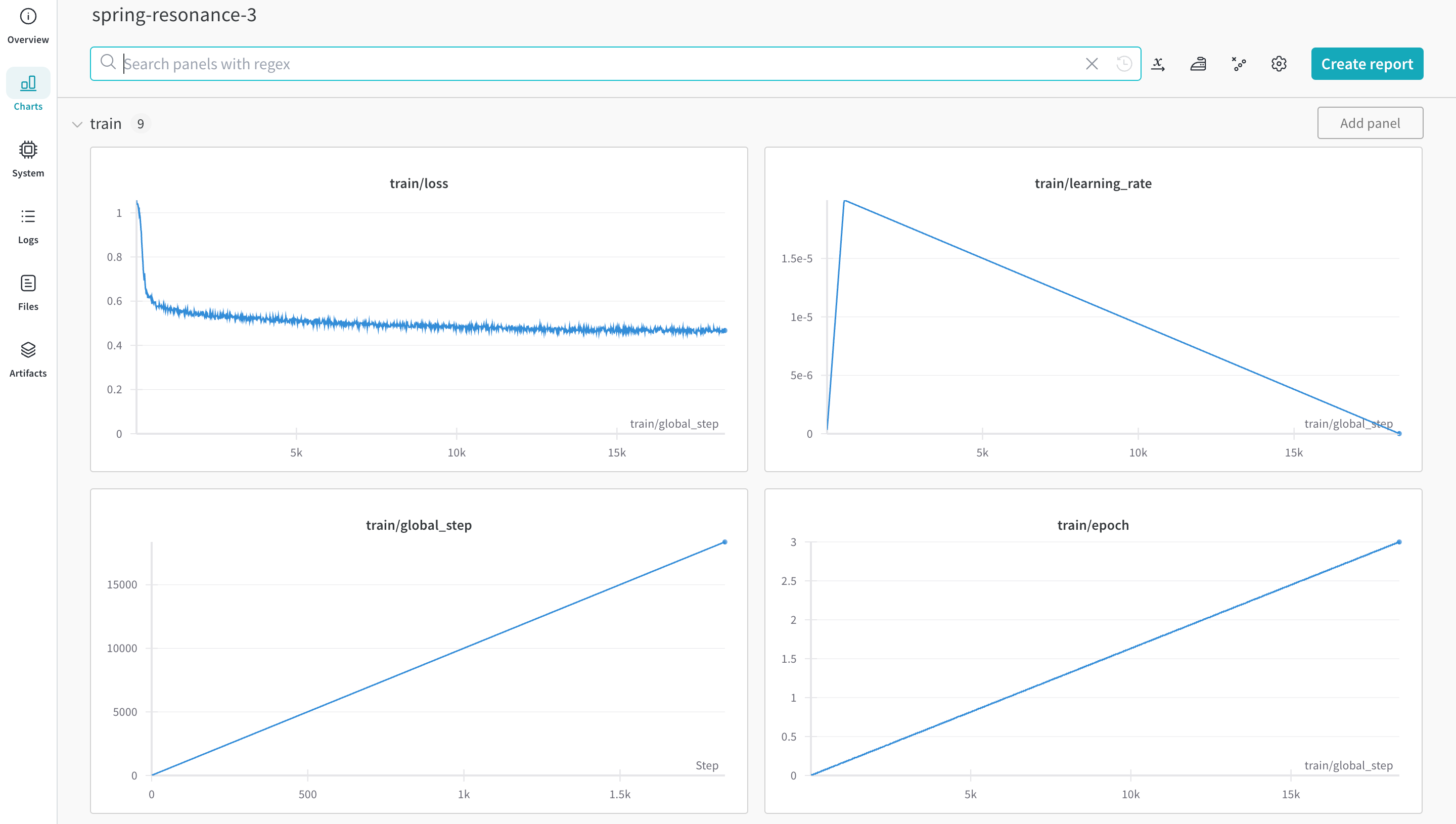

コマンドラインまたはノートブックから autotrain の高度な機能を使用してトレーニングを開始できます。--log 引数を使用するか、--log wandb を使用して、W&B run に結果をログします。

- Command Line

- Notebook