Try in Colab

OpenAI ファインチューニング インテグレーション を参照して、W&B を使用してファインチューニング実験、Models、および Datasets を追跡し、同僚と結果を共有する方法を学んでください。

OpenAI Python API ライブラリをインストール

W&B オートログ インテグレーションは OpenAI version 0.28.1 以下で動作します。 OpenAI Python API version 0.28.1 をインストールするには、次を実行します:OpenAI Python API を使用

1. autolog をインポートし、初期化

最初に、wandb.integration.openai から autolog をインポートし、初期化します。

wandb.init() が受け入れる引数の辞書を autolog に渡すことができます。これにはプロジェクト名、チーム名、エンティティなどが含まれます。wandb.init についての詳細は、API リファレンスガイドを参照してください。

2. OpenAI API を呼び出す

OpenAI API への各呼び出しは、W&B に自動的にログされます。3. OpenAI API 入力とレスポンスを確認

ステップ 1 でautolog により生成された W&B run リンクをクリックしてください。これにより、W&B App のプロジェクトワークスペースにリダイレクトされます。

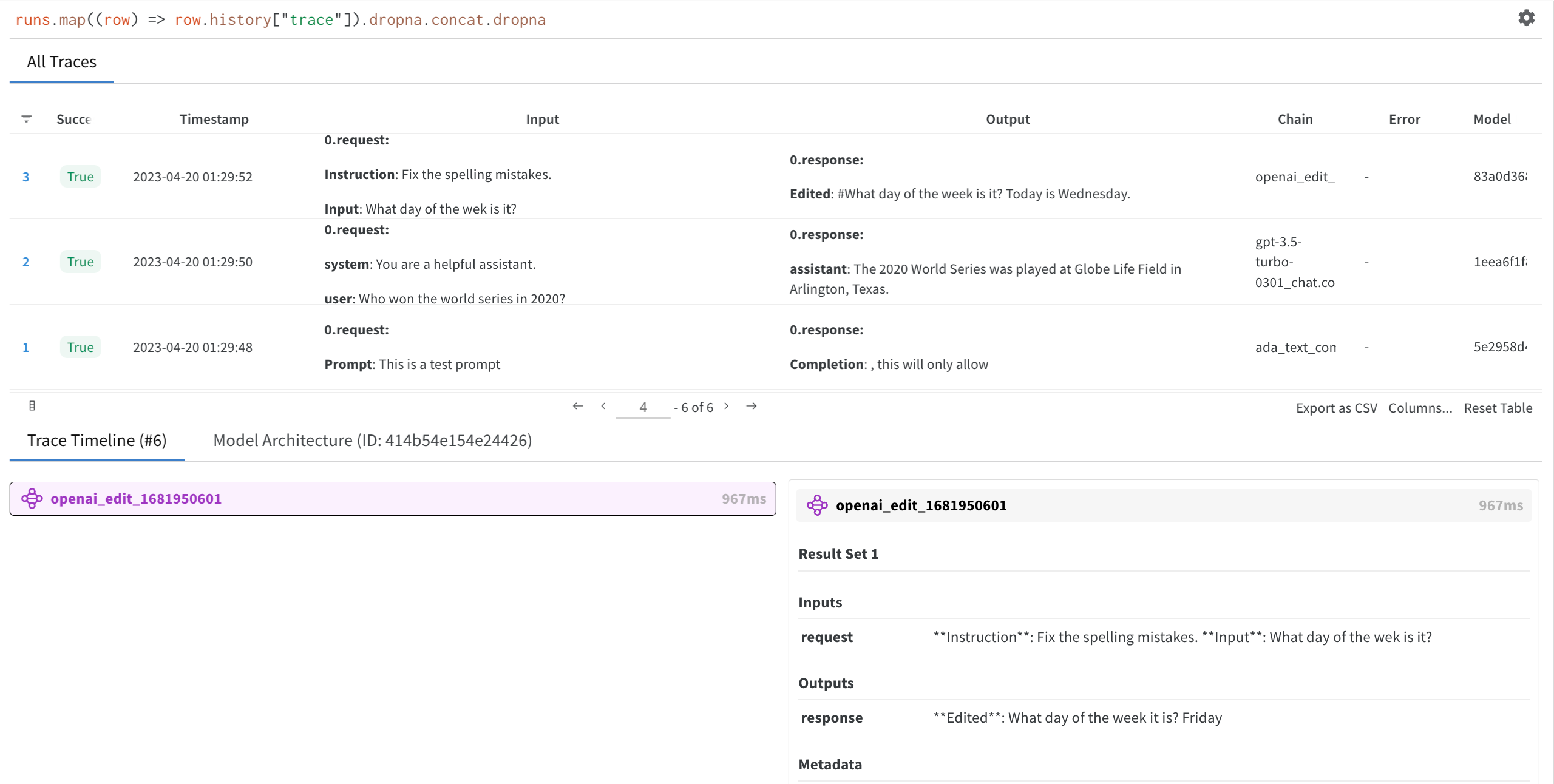

作成した run を選択すると、トレーステーブル、トレースタイムライン、使用した OpenAI LLM のモデルアーキテクチャーを確認することができます。

オートログをオフにする

W&B は、OpenAI API の使用を終了した際に、disable() を呼び出してすべての W&B プロセスを閉じることを推奨します。