Try in Colab

W&B를 사용하여 파인튜닝 Experiments, Models, Datasets을 추적하고 결과를 동료와 공유하는 방법에 대한 자세한 내용은 OpenAI 파인튜닝 인테그레이션을 참조하세요.

OpenAI Python API 라이브러리 설치

W&B autolog 인테그레이션은 OpenAI 버전 0.28.1 이하에서 작동합니다. OpenAI Python API 버전 0.28.1을 설치하려면 다음을 실행합니다.OpenAI Python API 사용

1. autolog 임포트 및 초기화

먼저wandb.integration.openai에서 autolog를 임포트하고 초기화합니다.

wandb.init()이 허용하는 인수가 있는 사전을 autolog에 전달할 수 있습니다. 여기에는 프로젝트 이름, 팀 이름, Entity 등이 포함됩니다. wandb.init에 대한 자세한 내용은 API Reference Guide를 참조하세요.

2. OpenAI API 호출

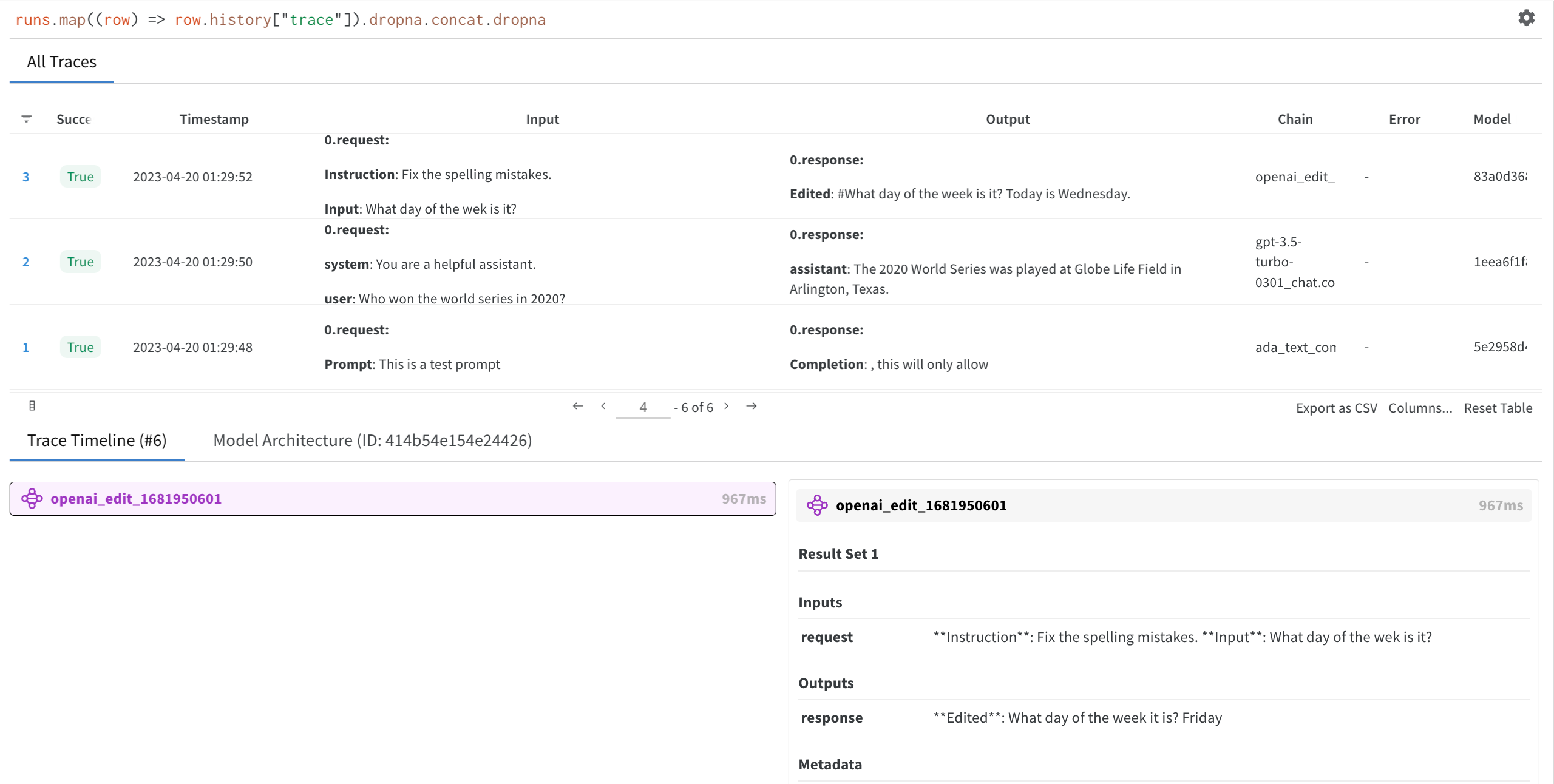

OpenAI API를 호출할 때마다 W&B에 자동으로 기록됩니다.3. OpenAI API 입력 및 응답 보기

1단계에서autolog에 의해 생성된 W&B run 링크를 클릭합니다. 그러면 W&B 앱의 프로젝트 Workspace로 리디렉션됩니다.

생성한 Run을 선택하여 추적 테이블, 추적 타임라인 및 사용된 OpenAI LLM의 모델 아키텍처를 봅니다.

autolog 끄기

OpenAI API 사용을 마친 후에는 모든 W&B 프로세스를 닫기 위해disable()을 호출하는 것이 좋습니다.