Try in Colab

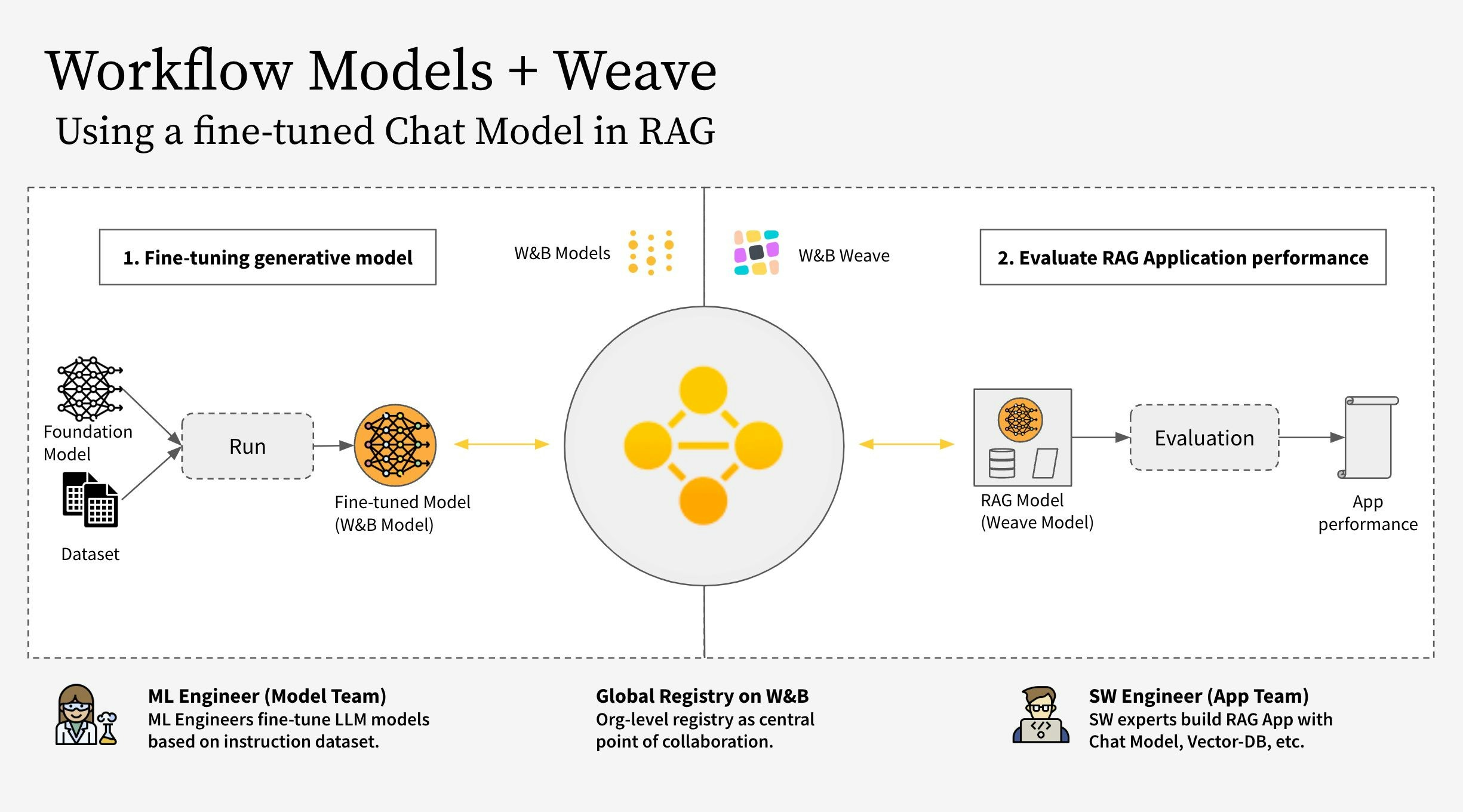

- The Model Team: 모델 구축 Team 은 새로운 Chat Model (Llama 3.2)을 파인튜닝하고 W&B Models 를 사용하여 레지스트리에 저장합니다.

- The App Team: 앱 개발 Team 은 Chat Model 을 검색하여 W&B Weave 를 사용하여 새로운 RAG 챗봇을 만들고 평가합니다.

- W&B Weave 로 RAG 앱 코드 계측

- LLM (예: Llama 3.2, 다른 LLM으로 대체 가능)을 파인튜닝하고 W&B Models 로 추적

- 파인튜닝된 모델을 W&B Registry 에 로그

- 새로운 파인튜닝된 모델로 RAG 앱을 구현하고 W&B Weave 로 앱을 평가

- 결과에 만족하면 업데이트된 Rag 앱에 대한 참조를 W&B Registry 에 저장

RagModel은 완전한 RAG 앱으로 간주할 수 있는 최상위 weave.Model입니다. 여기에는 ChatModel, 벡터 데이터베이스 및 프롬프트가 포함되어 있습니다. ChatModel은 또한 W&B Registry 에서 아티팩트를 다운로드하는 코드를 포함하는 또 다른 weave.Model이며 RagModel의 일부로 다른 챗봇 모델을 지원하도록 변경할 수 있습니다. 자세한 내용은 Weave의 전체 모델 을 참조하십시오.

1. 설정

먼저weave 와 wandb 를 설치한 다음 API 키로 로그인합니다. API 키는 https://wandb.ai/settings 에서 생성하고 볼 수 있습니다.

2. 아티팩트를 기반으로 ChatModel 만들기

Registry 에서 파인튜닝된 챗봇 모델을 검색하고, 다음 단계에서 RagModel 에 직접 연결하기 위해 weave.Model 을 만듭니다. 기존의 ChatModel 과 동일한 파라미터를 사용하며, init 과 predict 만 변경됩니다.

unsloth 라이브러리를 사용하여 더 빠르게 만들기 위해 다양한 Llama-3.2 모델을 파인튜닝했습니다. 따라서 Registry 에서 다운로드한 모델을 로드하기 위해 어댑터가 있는 특수한 unsloth.FastLanguageModel 또는 peft.AutoPeftModelForCausalLM 모델을 사용합니다. Registry 의 “Use” 탭에서 로딩 코드를 복사하여 model_post_init 에 붙여넣습니다.

3. 새로운 ChatModel 버전을 RagModel 에 통합

파인튜닝된 챗봇 모델에서 RAG 앱을 구축하면 특히 대화형 AI 시스템의 성능과 다양성을 향상시키는 데 여러 가지 이점을 제공할 수 있습니다.

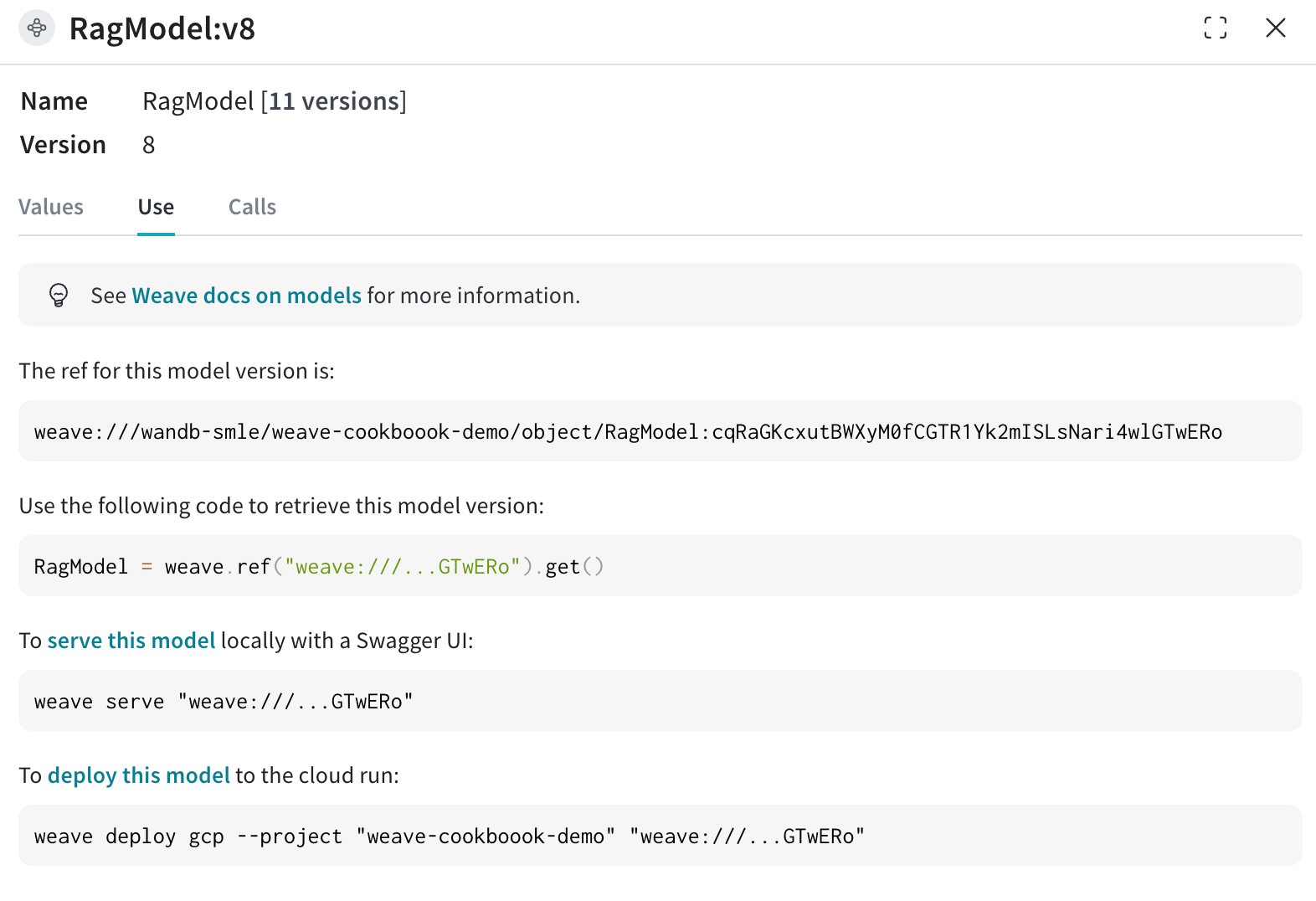

이제 기존 Weave 프로젝트에서 RagModel 을 검색하고 (아래 이미지에 표시된 대로 사용 탭에서 현재 RagModel 에 대한 Weave 참조를 가져올 수 있음) ChatModel 을 새 모델로 교체합니다. 다른 구성 요소(VDB, 프롬프트 등)를 변경하거나 다시 만들 필요가 없습니다!

4. 기존 Models Run 에 연결하여 새로운 weave.Evaluation 실행

마지막으로 기존 weave.Evaluation 에서 새 RagModel 을 평가합니다. 통합을 최대한 쉽게 만들기 위해 다음 변경 사항을 포함합니다.

Models 관점에서:

- Registry 에서 모델을 가져오면 챗봇 모델의 E2E 계보의 일부인 새로운

wandb.run이 생성됩니다. - 해당 Weave 페이지로 이동할 수 있도록 모델 Team 이 링크를 클릭할 수 있도록 실행 구성에 Trace ID (현재 eval ID 포함)를 추가합니다.

- 아티팩트 / Registry 링크를

ChatModel의 입력으로 저장 (즉,RagModel) weave.attributes로 traces 에 run.id 를 추가 열로 저장