仕組み

以下の数ステップで、機械学習の実験を追跡できます。- W&B Run を作成します。

- 学習率やモデルのタイプなどのハイパーパラメーターの辞書を、設定 (

wandb.Run.config) に保存します。 - トレーニングループ内で、精度 (accuracy) や損失 (loss) などのメトリクス (

wandb.Run.log()) を時系列でログに記録します。 - モデルの重みや予測結果のテーブルなど、run の出力を保存します。

クイックスタート

ユースケースに合わせて、W&B Experiments を使い始めるための以下のリソースを確認してください。- データセットの Artifacts を作成、追跡、使用するための W&B Python SDK コマンドのステップバイステップの概要については、W&B クイックスタート をお読みください。

- このチャプターでは、以下の方法について詳しく説明します。

- 実験の作成

- 実験の設定

- 実験からのデータのログ記録

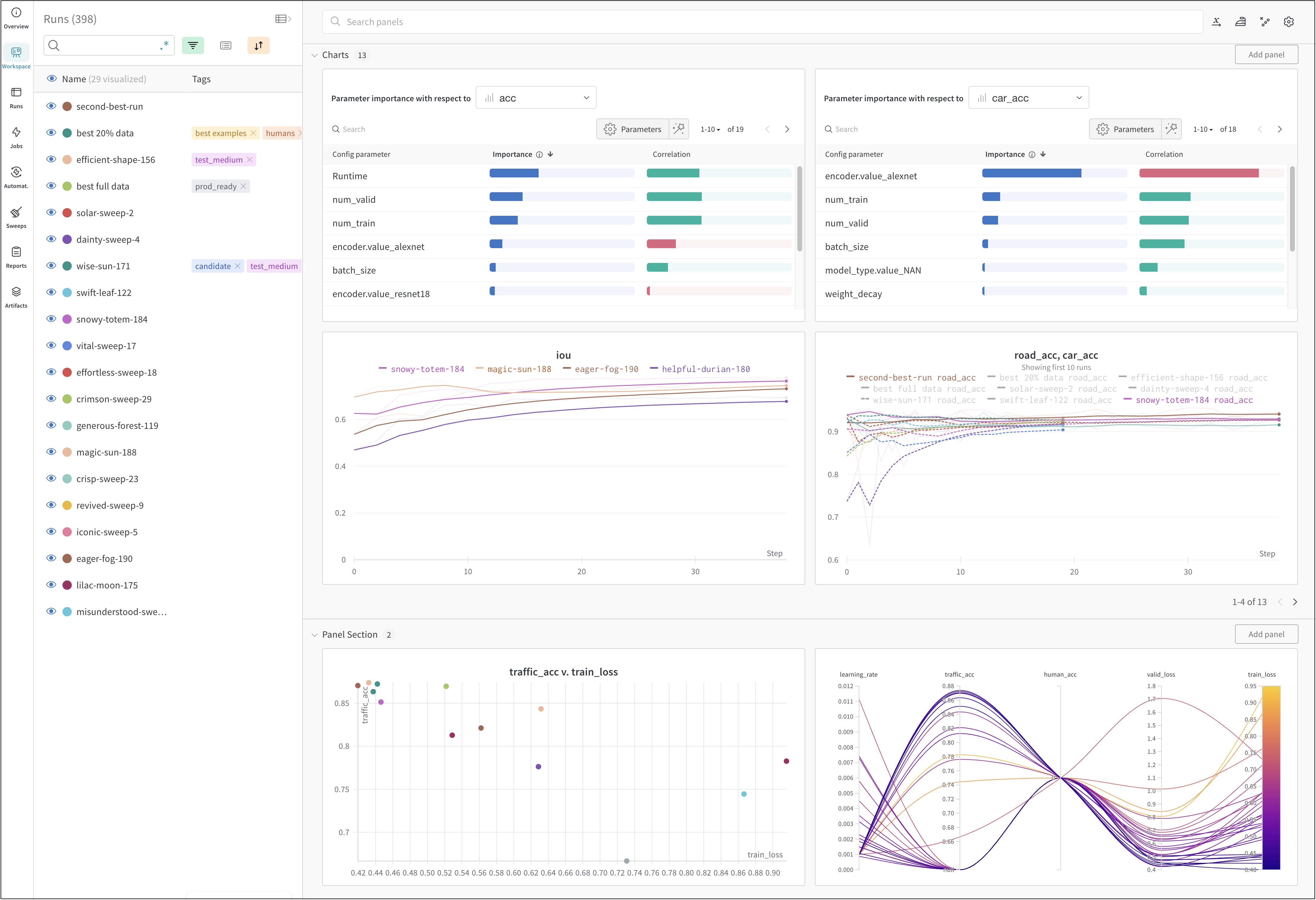

- 実験結果の表示

- W&B API リファレンスガイド 内の W&B Python ライブラリ を参照してください。