기본 예제: Weave로 Llama 3.1 8B Trace 하기

이 예제는 Llama 3.1 8B 모델에 프롬프트를 보내고 Weave로 해당 호출을 Trace 하는 방법을 보여줍니다. Tracing은 LLM 호출의 전체 입력 및 출력을 캡처하고, 성능을 모니터링하며, Weave UI에서 결과를 분석할 수 있게 해줍니다. 이 예제에서:- 채팅 완성 요청을 생성하는

@weave.op()데코레이터가 지정된 함수를 정의합니다. - Trace 가 기록되어 사용자의 W&B Entity 및 Project 에 연결됩니다.

- 함수가 자동으로 Trace 되어 입력, 출력, 지연 시간(latency) 및 메타데이터를 로그합니다.

- 결과가 터미널에 출력되며, https://wandb.ai의 Traces 탭에 Trace 가 나타납니다.

- 터미널에 출력된 링크를 클릭합니다 (예:

https://wandb.ai/<your-team>/<your-project>/r/call/01977f8f-839d-7dda-b0c2-27292ef0e04g). - 또는 https://wandb.ai로 이동하여 Traces 탭을 선택합니다.

고급 예제: Weave Evaluations 및 Leaderboards 사용하기

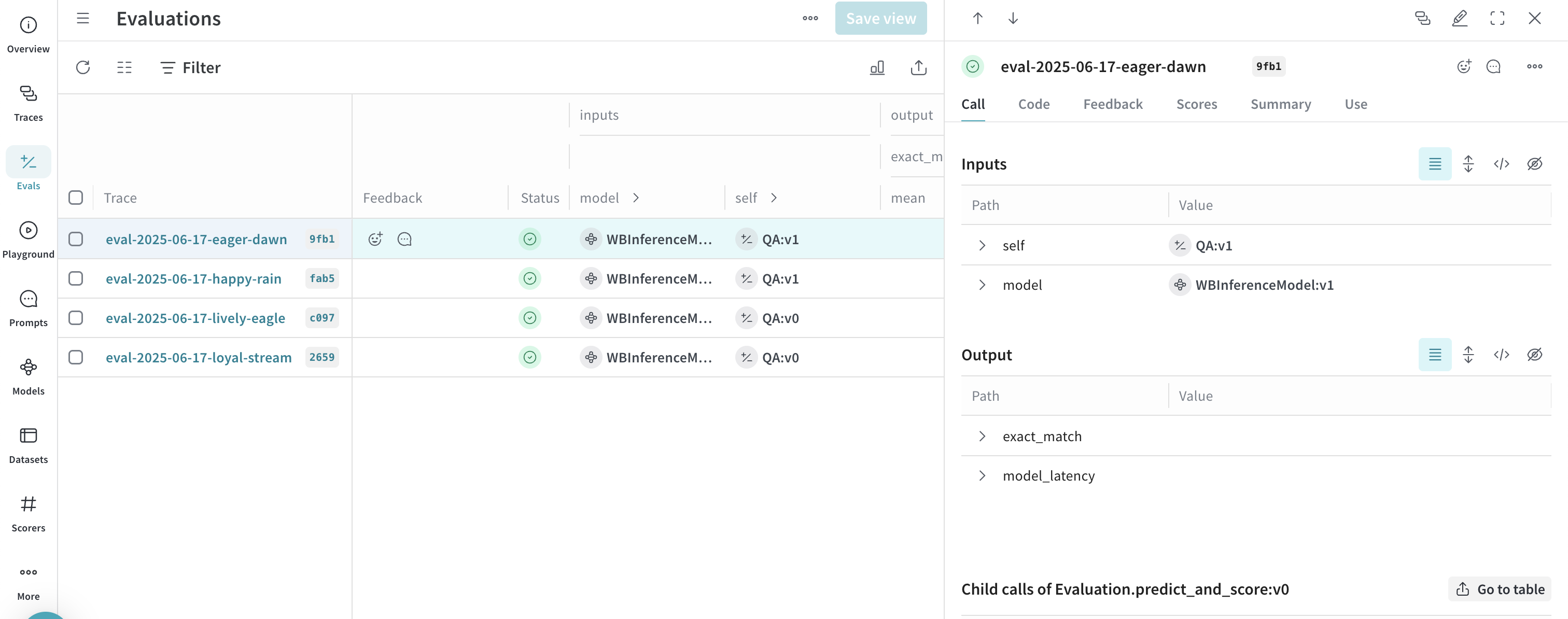

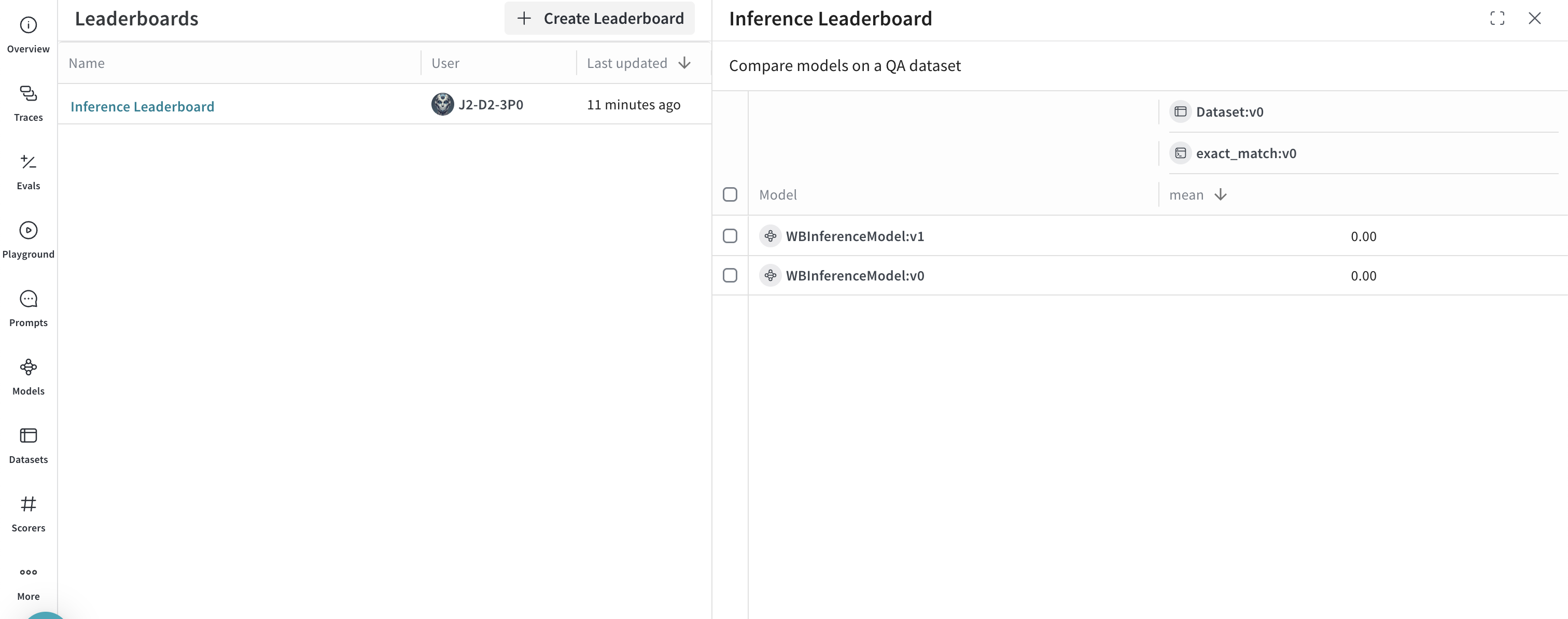

모델 호출을 Trace 하는 것 외에도 성능을 평가하고 Leaderboard 를 게시할 수 있습니다. 이 예제는 질문-답변 데이터셋에서 두 모델을 비교합니다. 이 예제를 실행하기 전에, 사전 요구 사항을 완료하세요.- Traces 탭을 선택하여 Trace 확인

- Evals 탭을 선택하여 모델 평가 확인

- Leaders 탭을 선택하여 생성된 Leaderboard 확인