작동 방식

몇 줄의 코드만으로 기계학습 실험을 트래킹할 수 있습니다:- W&B Run을 생성합니다.

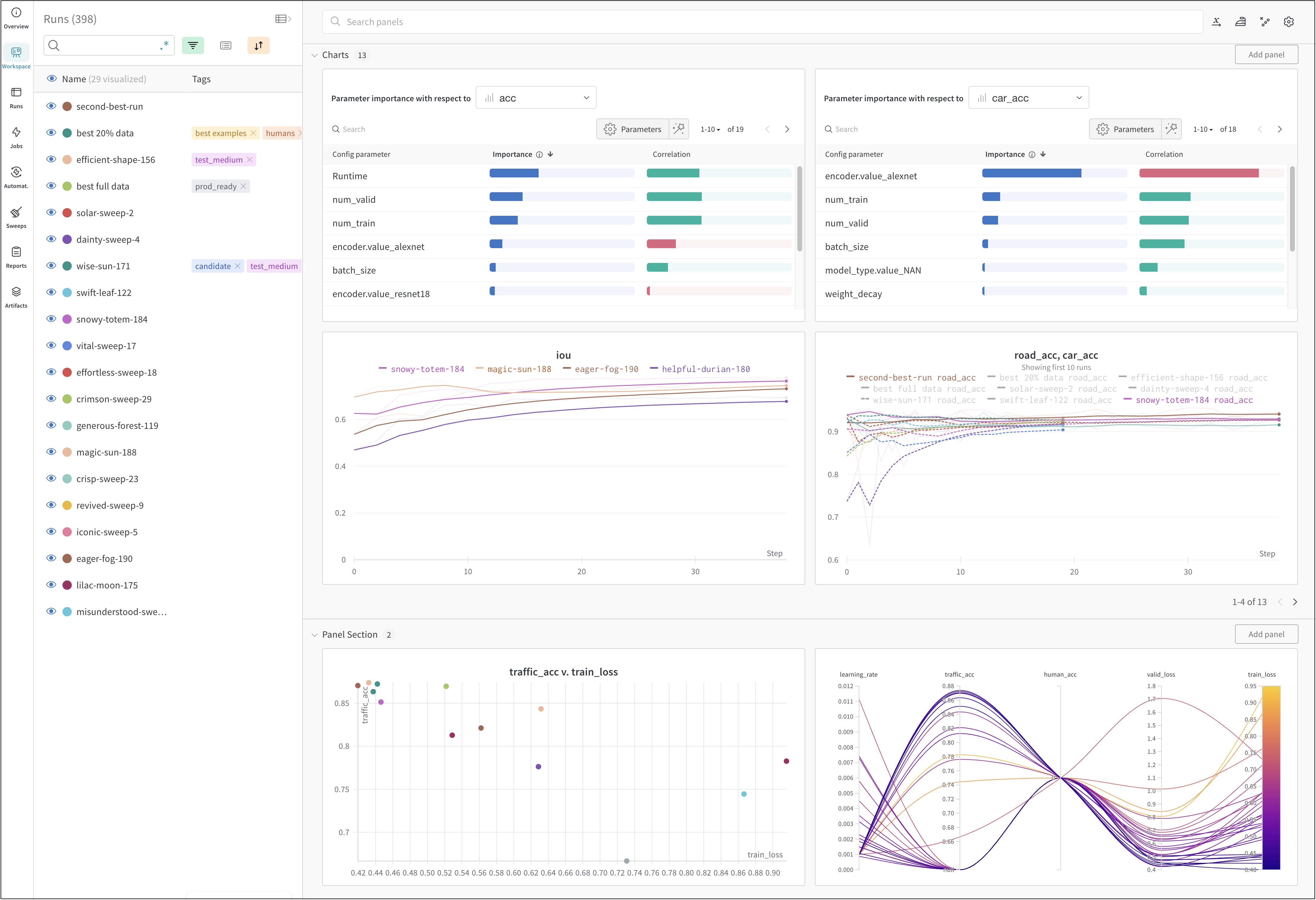

- 학습률이나 모델 유형과 같은 하이퍼파라미터 사전을 설정(

wandb.Run.config)에 저장합니다. - 트레이닝 루프에서 정확도와 손실 같은 메트릭(

wandb.Run.log())을 시간에 따라 로그합니다. - 모델 가중치나 예측값 테이블과 같은 run의 결과물을 저장합니다.

시작하기

사용자의 유스 케이스에 따라 W&B Experiments를 시작하기 위한 다음 리소스들을 살펴보세요:- 데이터셋 아티팩트를 생성, 트래킹 및 사용하는 데 필요한 W&B Python SDK 코맨드에 대한 단계별 개요는 W&B 퀵스타트를 읽어보세요.

- 이 챕터에서 다음 방법들을 알아보세요:

- 실험 생성하기

- 실험 설정하기

- 실험 데이터 로그하기

- 실험 결과 보기

- W&B API 레퍼런스 가이드 내의 W&B Python 라이브러리를 살펴보세요.