- 모델 성능 저하(regression) 추적

- 공유 평가 워크플로우 조정

Leaderboard 생성은 Weave UI와 Weave Python SDK에서만 가능합니다. TypeScript 사용자는 Weave UI 를 사용하여 Leaderboards를 생성하고 관리할 수 있습니다.

Leaderboard 생성하기

Weave UI 또는 프로그래밍 방식 으로 Leaderboard를 생성할 수 있습니다.UI 사용하기

Weave UI에서 직접 Leaderboards를 생성하고 커스텀하려면 다음 단계를 따르세요:- Weave UI에서 Leaders 섹션으로 이동합니다. 보이지 않는 경우 More → Leaders 를 클릭합니다.

- + New Leaderboard 를 클릭합니다.

- Leaderboard Title 필드에 설명이 포함된 이름(예:

summarization-benchmark-v1)을 입력합니다. - 선택 사항으로, 이 Leaderboard가 무엇을 비교하는지 설명하는 내용을 추가합니다.

- 열 추가 를 통해 표시할 평가와 메트릭을 정의합니다.

- 레이아웃이 만족스러우면 Leaderboard를 저장하고 게시하여 다른 사람들과 공유하세요.

열 추가 (Add columns)

Leaderboard의 각 열은 특정 평가의 메트릭을 나타냅니다. 열을 구성하려면 다음을 지정합니다:- Evaluation: 드롭다운에서 평가 run을 선택합니다 (이전에 생성되어 있어야 함).

- Scorer: 해당 평가에서 사용된 스코어링 함수(예:

jaccard_similarity,simple_accuracy)를 선택합니다. - Metric: 표시할 요약 메트릭을 선택합니다(예:

mean,true_fraction등).

⋯)를 클릭하세요. 다음 작업을 수행할 수 있습니다:

- Move before / after – 열 순서 변경

- Duplicate – 열 정의 복사

- Delete – 열 삭제

- Sort ascending – Leaderboard의 기본 정렬 설정 (다시 클릭하면 내림차순으로 전환)

Python

Leaderboard를 생성하고 게시하려면 다음 단계를 따르세요:-

테스트 데이터셋을 정의합니다. 내장된

Dataset을 사용하거나 입력과 타겟 리스트를 수동으로 정의할 수 있습니다: -

하나 이상의 scorers 를 정의합니다:

-

Evaluation을 생성합니다: -

평가할 모델들을 정의합니다:

-

평가를 실행합니다:

-

Leaderboard를 생성합니다:

-

Leaderboard를 게시합니다.

-

결과를 가져옵니다:

엔드투엔드 Python 예시

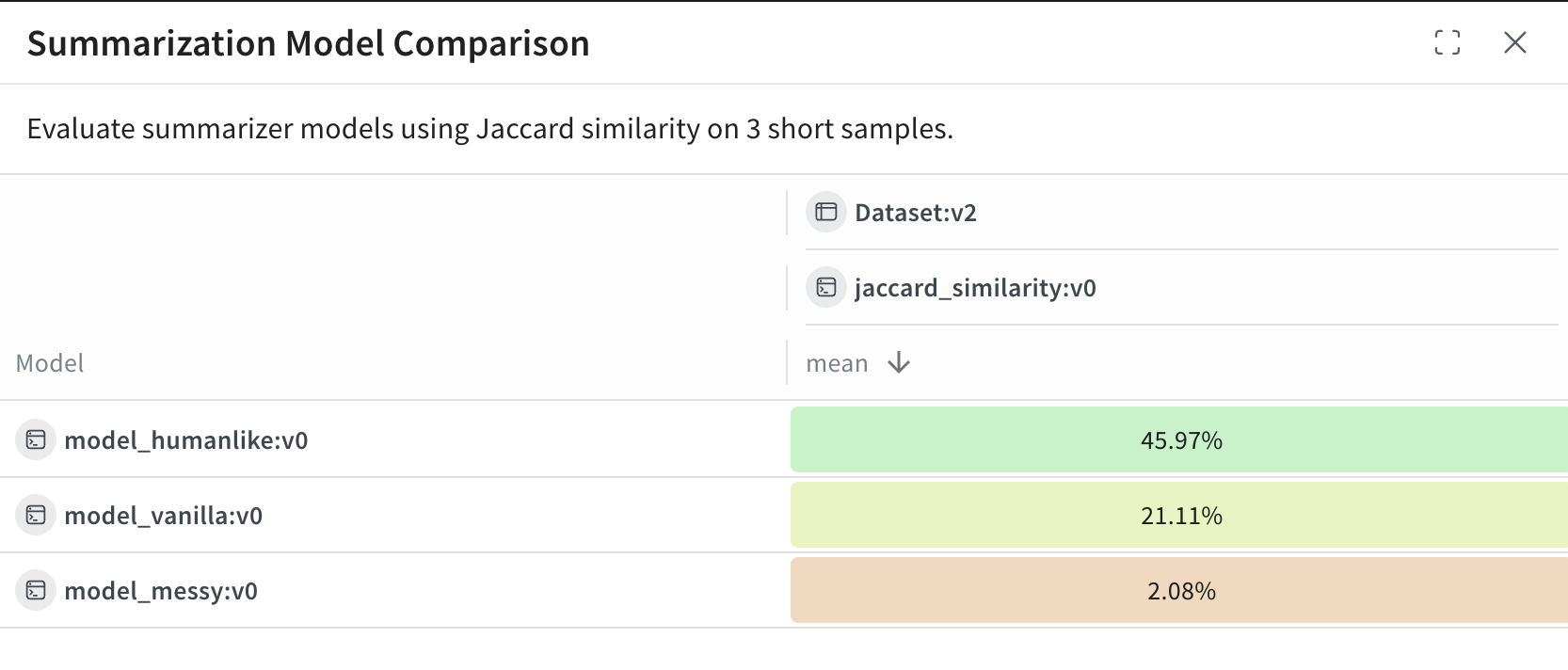

다음 예시는 Weave Evaluations를 사용하며, 커스텀 메트릭을 사용하여 공유 데이터셋에서 세 가지 요약 모델을 비교하는 Leaderboard를 생성합니다. 작은 벤치마크를 만들고, 각 모델을 평가하며, 자카드 유사도(Jaccard similarity) 로 각 모델의 점수를 매긴 후 결과를 Weave Leaderboard에 게시합니다.Leaderboard 확인 및 해석

스크립트 실행이 완료되면 Leaderboard를 확인하세요:- Weave UI 에서 Leaders 탭으로 이동합니다. 보이지 않는 경우 More 를 클릭한 다음 Leaders 를 선택합니다.

- 생성한 Leaderboard의 이름(예:

Summarization Model Comparison)을 클릭합니다.

model_humanlike, model_vanilla, model_messy)을 나타냅니다. mean 열은 모델의 출력과 참조 요약본 사이의 평균 자카드 유사도를 보여줍니다.

model_humanlike가 약 46%의 중첩도로 가장 우수한 성능을 보입니다.model_vanilla(단순 절단 방식)는 약 21%를 기록했습니다.- 의도적으로 성능을 낮춘

model_messy는 약 2%를 기록했습니다.