이것은 인터랙티브 노트북입니다. 로컬에서 실행하거나 아래 링크를 사용할 수 있습니다:

사전 요구 사항

시작하기 전에 필요한 라이브러리를 설치 및 임포트하고, W&B API 키를 가져온 다음 Weave 프로젝트를 초기화하세요.1. Weave를 사용하여 프롬프트 생성 및 반복 실험

모델이 엔티티를 적절하게 추출하도록 가이드하려면 훌륭한 프롬프트 엔지니어링이 필수적입니다. 먼저, 이미지 데이터에서 무엇을 추출하고 어떻게 형식을 맞출지 모델에 지시하는 기본 프롬프트를 만듭니다. 그런 다음, 추적 및 반복 실험을 위해 프롬프트를 Weave에 저장합니다.2. 데이터셋 가져오기

다음으로, OCR 파이프라인의 입력으로 사용할 수필 메모 데이터셋을 가져옵니다. 데이터셋의 이미지는 이미base64로 인코딩되어 있어, 별도의 전처리 없이 LLM에서 바로 데이터를 사용할 수 있습니다.

3. NER 파이프라인 구축

이제 NER 파이프라인을 구축합니다. 파이프라인은 두 개의 함수로 구성됩니다:encode_image함수: 데이터셋에서 PIL 이미지를 받아 VLM에 전달할 수 있는 이미지의base64인코딩 문자열 표현을 반환합니다.extract_named_entities_from_image함수: 이미지와 시스템 프롬프트를 받아 시스템 프롬프트에 설명된 대로 해당 이미지에서 추출된 엔티티를 반환합니다.

named_entity_recognation 함수를 만듭니다:

- 이미지 데이터를 NER 파이프라인으로 전달

- 결과가 포함된 올바른 형식의 JSON 반환

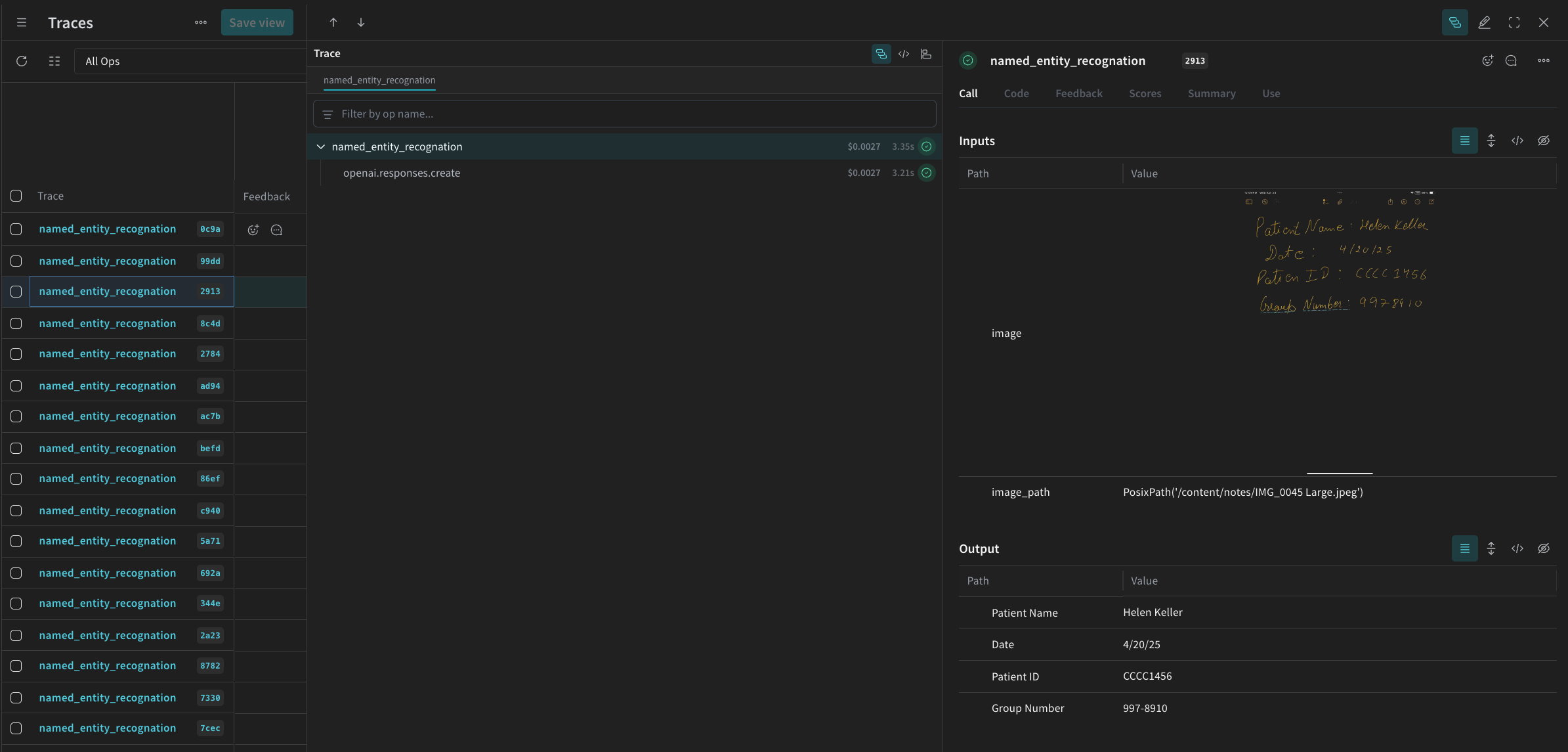

@weave.op() 데코레이터를 사용하여 W&B UI에서 함수 실행을 자동으로 추적하고 기록하세요.

named_entity_recognation이 실행될 때마다 전체 추적 결과가 Weave UI에 표시됩니다. 추적 내용을 보려면 Weave 프로젝트의 Traces 탭으로 이동하세요.

processing_results.json에 저장합니다. 결과는 Weave UI에서도 확인할 수 있습니다.

4. Weave를 사용하여 파이프라인 평가

VLM을 사용하여 NER을 수행하는 파이프라인을 만들었으므로, 이제 Weave를 사용하여 이를 체계적으로 평가하고 성능을 확인할 수 있습니다. Weave의 평가에 대한 자세한 내용은 Evaluations 개요에서 확인할 수 있습니다. Weave Evaluation의 핵심 요소는 Scorers입니다. Scorer는 AI 출력을 평가하고 평가 메트릭을 반환하는 데 사용됩니다. AI의 출력을 받아 분석하고 결과 사전을 반환합니다. Scorer는 필요한 경우 입력 데이터를 참조로 사용할 수 있으며, 평가 결과에 대한 설명이나 추론과 같은 추가 정보를 출력할 수도 있습니다. 이 섹션에서는 파이프라인을 평가하기 위해 두 가지 Scorer를 만듭니다:- Programatic Scorer

- LLM-as-a-judge Scorer

Programatic scorer

프로그래밍 방식의 Scorer인check_for_missing_fields_programatically는 모델 출력(named_entity_recognition 함수의 출력)을 받아 결과에서 어떤 keys가 누락되었거나 비어 있는지 식별합니다.

이 체크는 모델이 필드를 캡처하지 못한 샘플을 식별하는 데 유용합니다.

LLM-as-a-judge scorer

평가의 다음 단계에서는 평가가 실제 NER 성능을 반영하도록 이미지 데이터와 모델 출력을 모두 제공합니다. 모델 출력뿐만 아니라 이미지 내용도 명시적으로 참조됩니다. 이 단계에서 사용되는 Scorer인check_for_missing_fields_with_llm은 LLM(구체적으로 OpenAI의 gpt-4o)을 사용하여 점수를 매깁니다. eval_prompt의 내용에 명시된 대로 check_for_missing_fields_with_llm은 Boolean 값을 출력합니다. 모든 필드가 이미지의 정보와 일치하고 형식이 올바르면 Scorer는 true를 반환합니다. 필드가 누락되었거나, 비어 있거나, 올바르지 않거나, 일치하지 않는 경우 결과는 false가 되며 Scorer는 문제를 설명하는 메시지도 함께 반환합니다.

5. Evaluation 실행

마지막으로, 전달된dataset을 자동으로 루프하고 그 결과를 Weave UI에 함께 로깅하는 evaluation 호출을 정의합니다.

다음 코드는 평가를 시작하고 NER 파이프라인의 모든 출력에 대해 두 가지 Scorers를 적용합니다. 결과는 Weave UI의 Evals 탭에서 확인할 수 있습니다.