필수 구성 요소 설치

autotrain-advanced 와 wandb 를 설치합니다.

- Command Line

- Notebook

pass@1 에서 SoTA 결과를 달성하는 과정을 보여줍니다.

데이터셋 준비

Hugging Face AutoTrain 이 제대로 작동하려면 커스텀 CSV 데이터셋이 특정 형식을 갖추어야 합니다.-

트레이닝 파일에는 트레이닝에 사용될

text컬럼이 반드시 포함되어야 합니다. 최상의 결과를 얻으려면text컬럼의 데이터가### Human: Question?### Assistant: Answer.형식을 따라야 합니다.timdettmers/openassistant-guanaco에서 좋은 예시를 확인할 수 있습니다. 하지만, MetaMathQA 데이터셋 에는query,response,type컬럼이 포함되어 있습니다. 먼저 이 데이터셋을 전처리합니다.type컬럼을 제거하고query와response컬럼의 내용을### Human: Query?### Assistant: Response.형식의 새로운text컬럼으로 병합합니다. 트레이닝에는 결과 데이터셋인rishiraj/guanaco-style-metamath를 사용합니다.

autotrain 을 사용하여 트레이닝하기

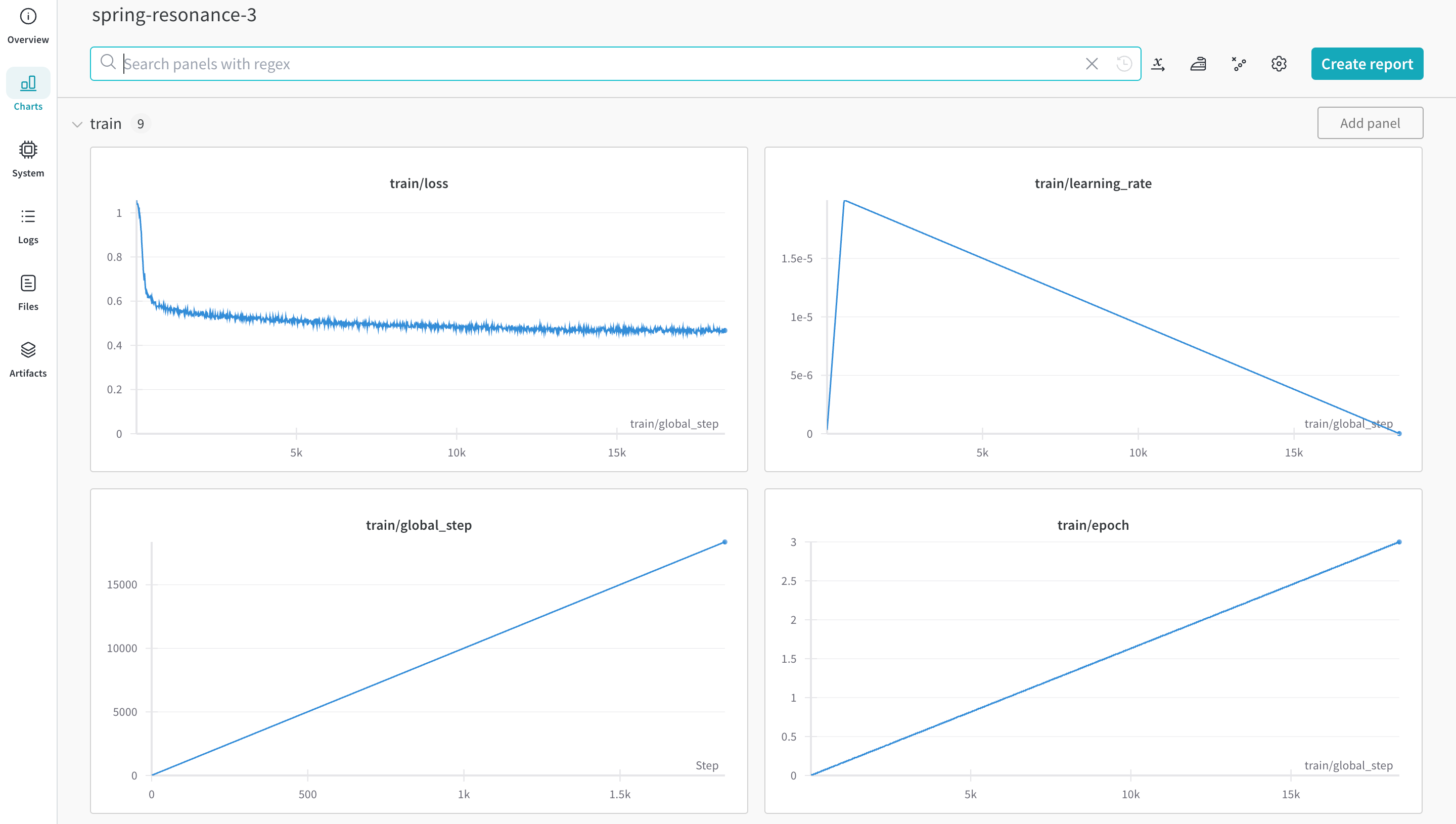

커맨드라인이나 노트북에서 autotrain advanced 를 사용하여 트레이닝을 시작할 수 있습니다. --log 인수를 사용하거나, --log wandb 를 사용하여 결과를 W&B Run 에 로그합니다.

- Command Line

- Notebook