시작하기

가입 및 API 키 생성

API 키는 W&B에 사용자 머신을 인증하는 데 사용됩니다. 사용자 프로필에서 API 키를 생성할 수 있습니다.For a more streamlined approach, create an API key by going directly to User Settings. Copy the newly created API key immediately and save it in a secure location such as a password manager.

- 오른쪽 상단에 있는 사용자 프로필 아이콘을 클릭합니다.

- User Settings를 선택한 다음 API Keys 섹션으로 스크롤합니다.

wandb 라이브러리 설치 및 로그인

로컬에 wandb 라이브러리를 설치하고 로그인하려면 다음을 수행하세요:

- Command Line

- Python

- Python notebook

-

WANDB_API_KEY환경 변수를 생성한 API 키로 설정합니다. -

wandb라이브러리를 설치하고 로그인합니다.

메트릭 로그

차트 그리기

1단계: wandb 임포트 및 새로운 run 초기화

2단계: 차트 시각화

개별 차트

모델을 트레이닝하고 예측을 수행한 후, wandb에서 차트를 생성하여 예측값을 분석할 수 있습니다. 지원되는 전체 차트 목록은 아래의 지원되는 차트 섹션을 참조하세요.모든 차트

W&B에는 여러 관련 차트를 한 번에 그려주는plot_classifier와 같은 함수가 있습니다:

기존 Matplotlib 차트

Matplotlib으로 생성한 차트도 W&B 대시보드에 로그할 수 있습니다. 이를 위해서는 먼저plotly를 설치해야 합니다.

지원되는 차트

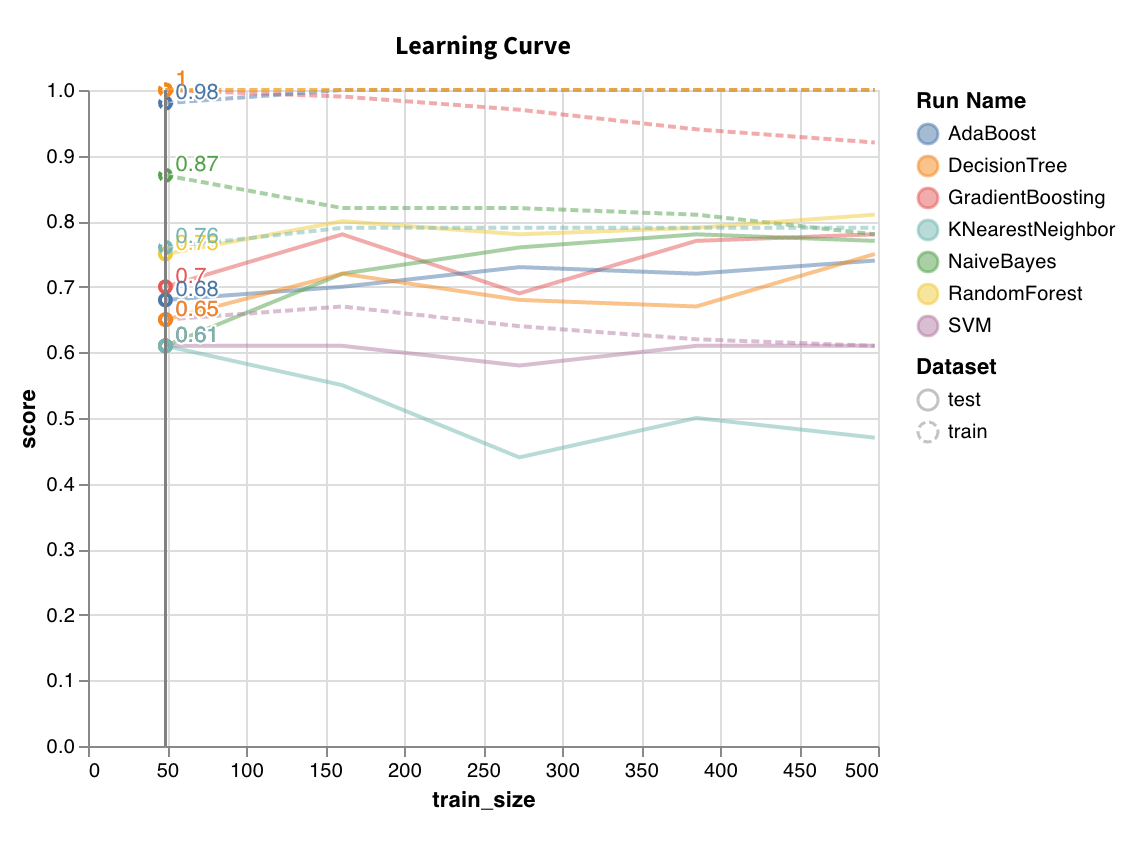

학습 곡선 (Learning curve)

wandb.sklearn.plot_learning_curve(model, X, y)

- model (clf 또는 reg): 학습된 회귀 모델 또는 분류기를 인수로 받습니다.

- X (arr): 데이터셋 피처.

- y (arr): 데이터셋 라벨.

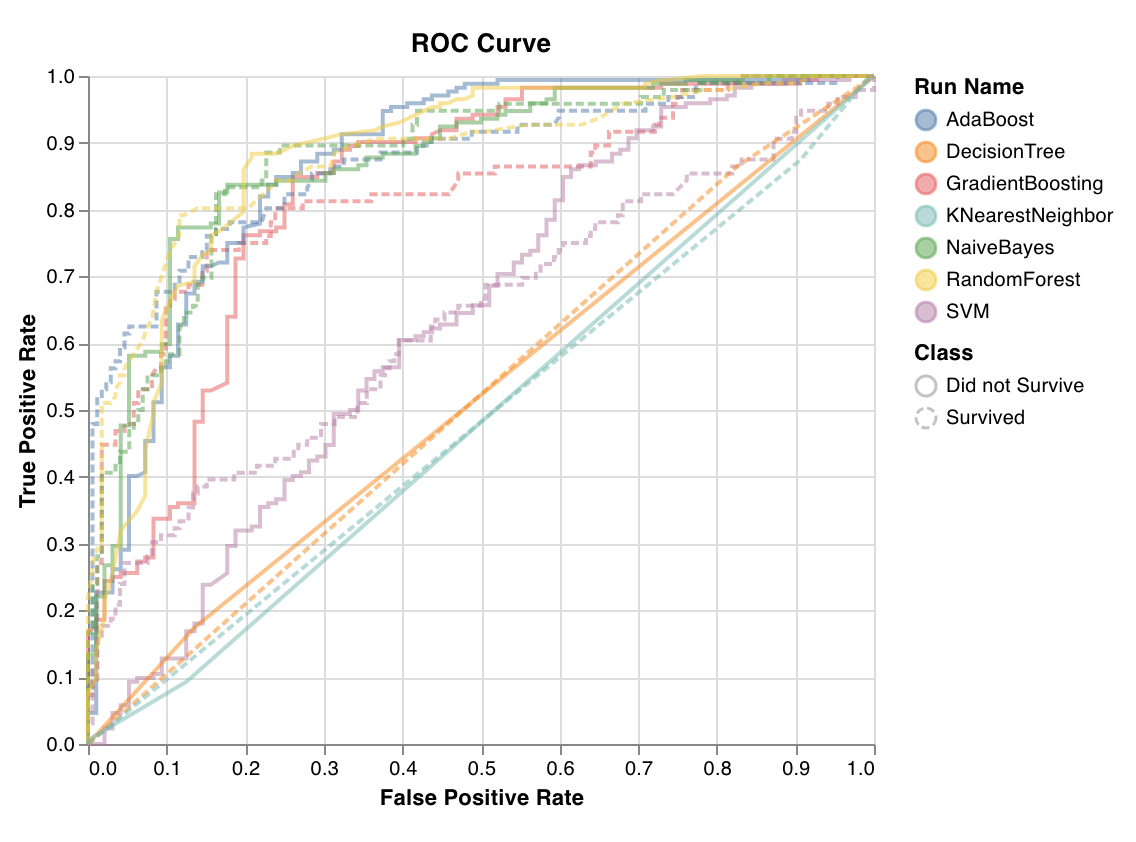

ROC

wandb.sklearn.plot_roc(y_true, y_probas, labels)

- y_true (arr): 테스트 세트 라벨.

- y_probas (arr): 테스트 세트 예측 확률.

- labels (list): 타겟 변수(y)의 이름이 지정된 라벨 목록.

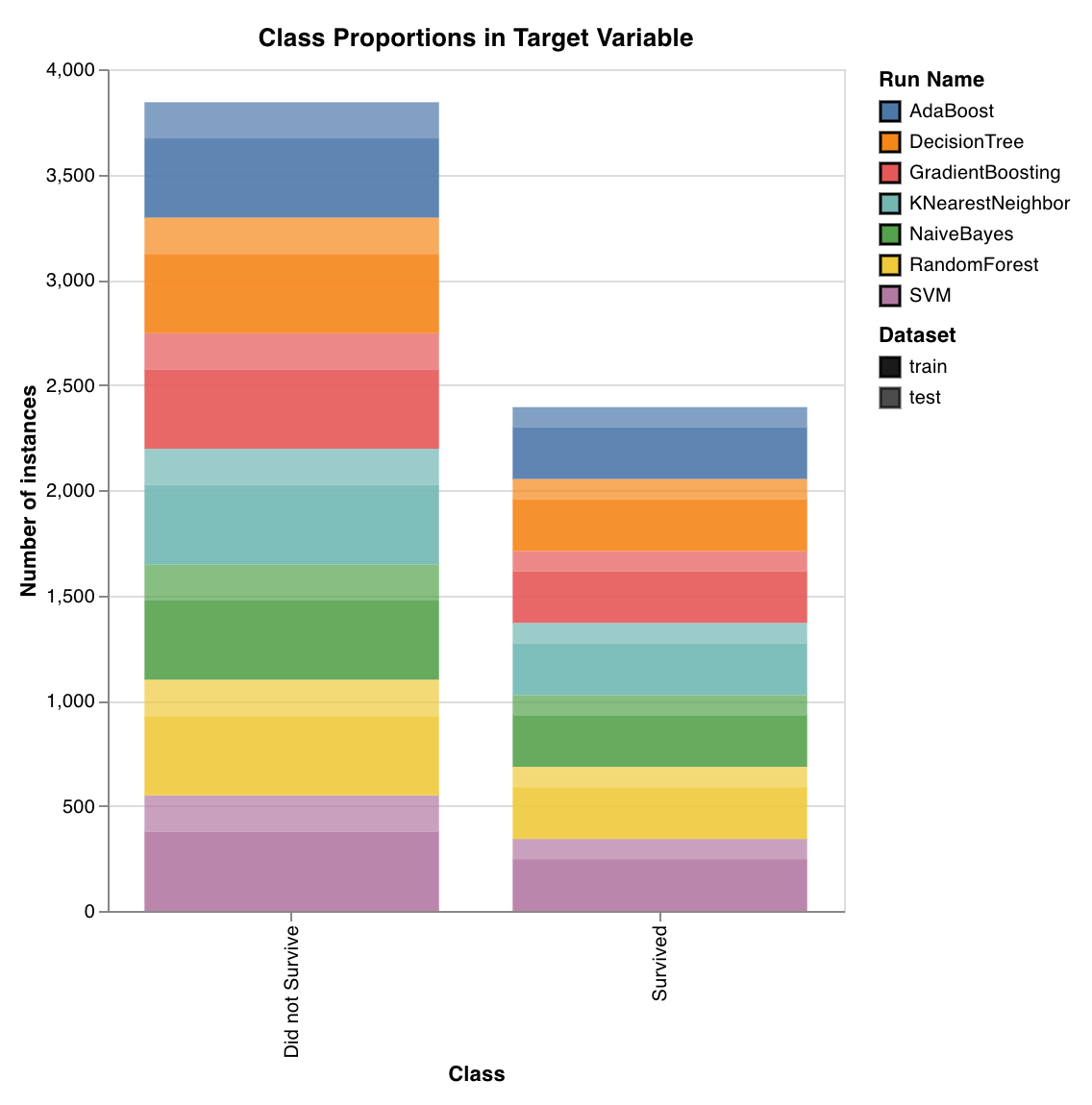

클래스 비율 (Class proportions)

wandb.sklearn.plot_class_proportions(y_train, y_test, ['dog', 'cat', 'owl'])

- y_train (arr): 트레이닝 세트 라벨.

- y_test (arr): 테스트 세트 라벨.

- labels (list): 타겟 변수(y)의 이름이 지정된 라벨 목록.

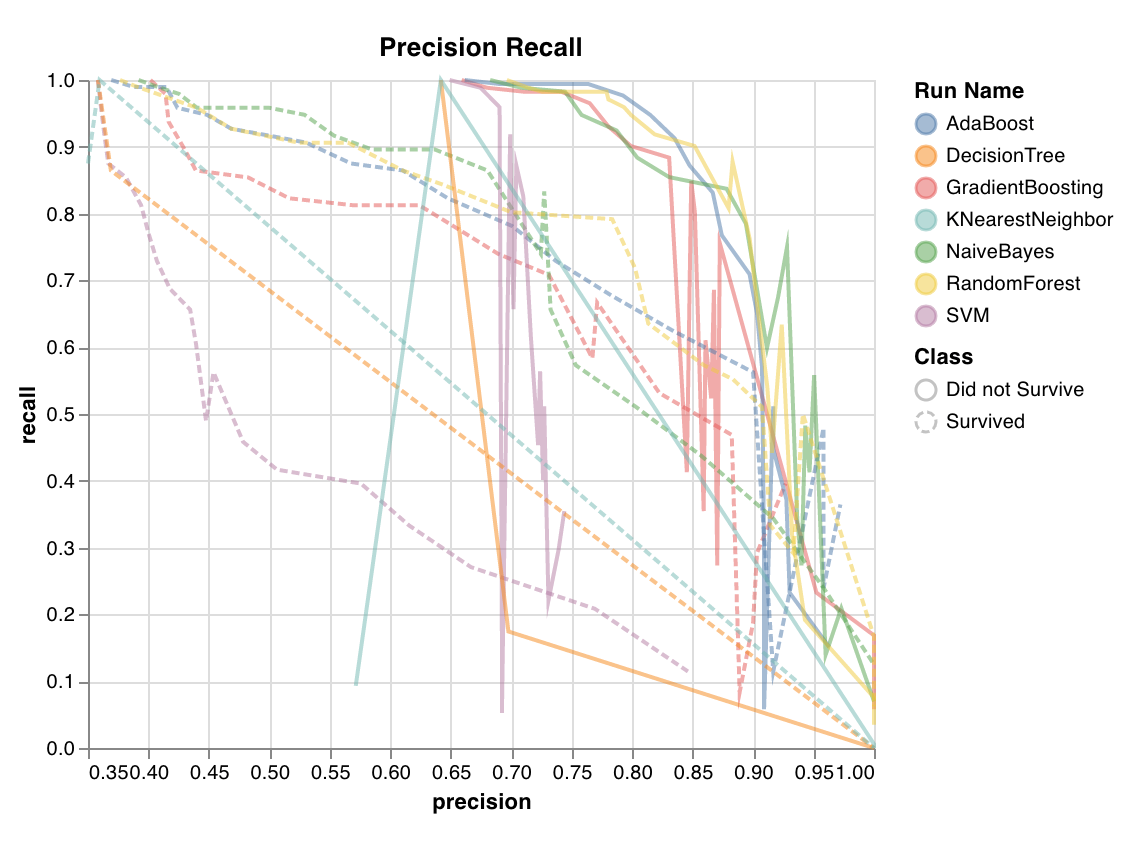

PR 곡선 (Precision recall curve)

wandb.sklearn.plot_precision_recall(y_true, y_probas, labels)

- y_true (arr): 테스트 세트 라벨.

- y_probas (arr): 테스트 세트 예측 확률.

- labels (list): 타겟 변수(y)의 이름이 지정된 라벨 목록.

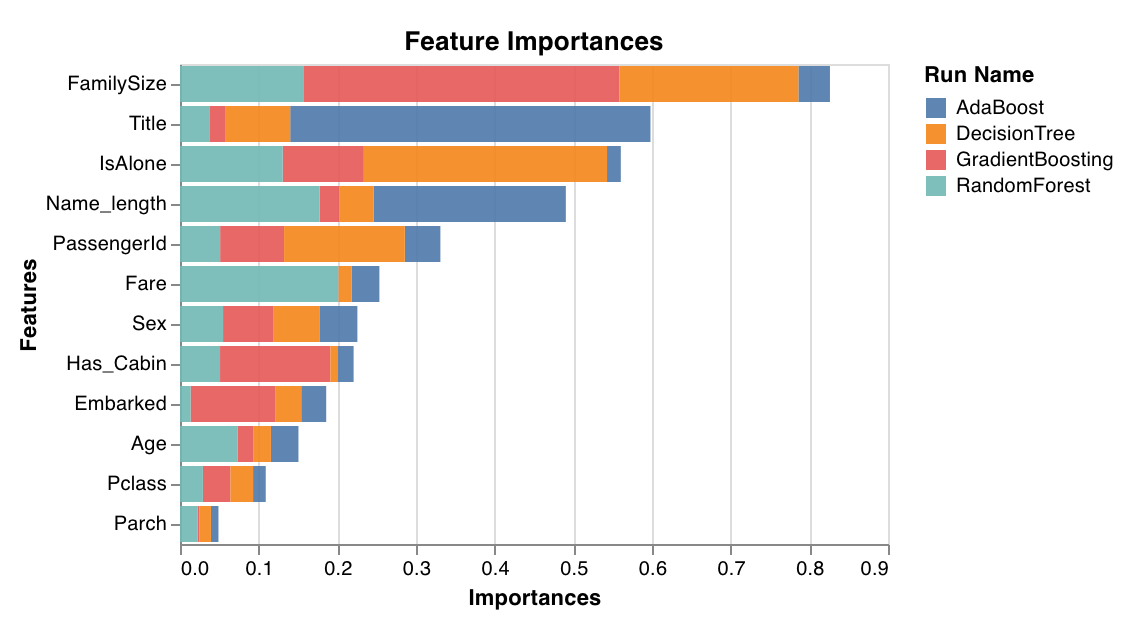

피처 중요도 (Feature importances)

feature_importances_ 속성을 가진 분류기에서만 작동합니다.

wandb.sklearn.plot_feature_importances(model, ['width', 'height, 'length'])

- model (clf): 학습된 분류기를 인수로 받습니다.

- feature_names (list): 피처의 이름 목록. 피처 인덱스를 해당 이름으로 교체하여 차트를 더 읽기 쉽게 만듭니다.

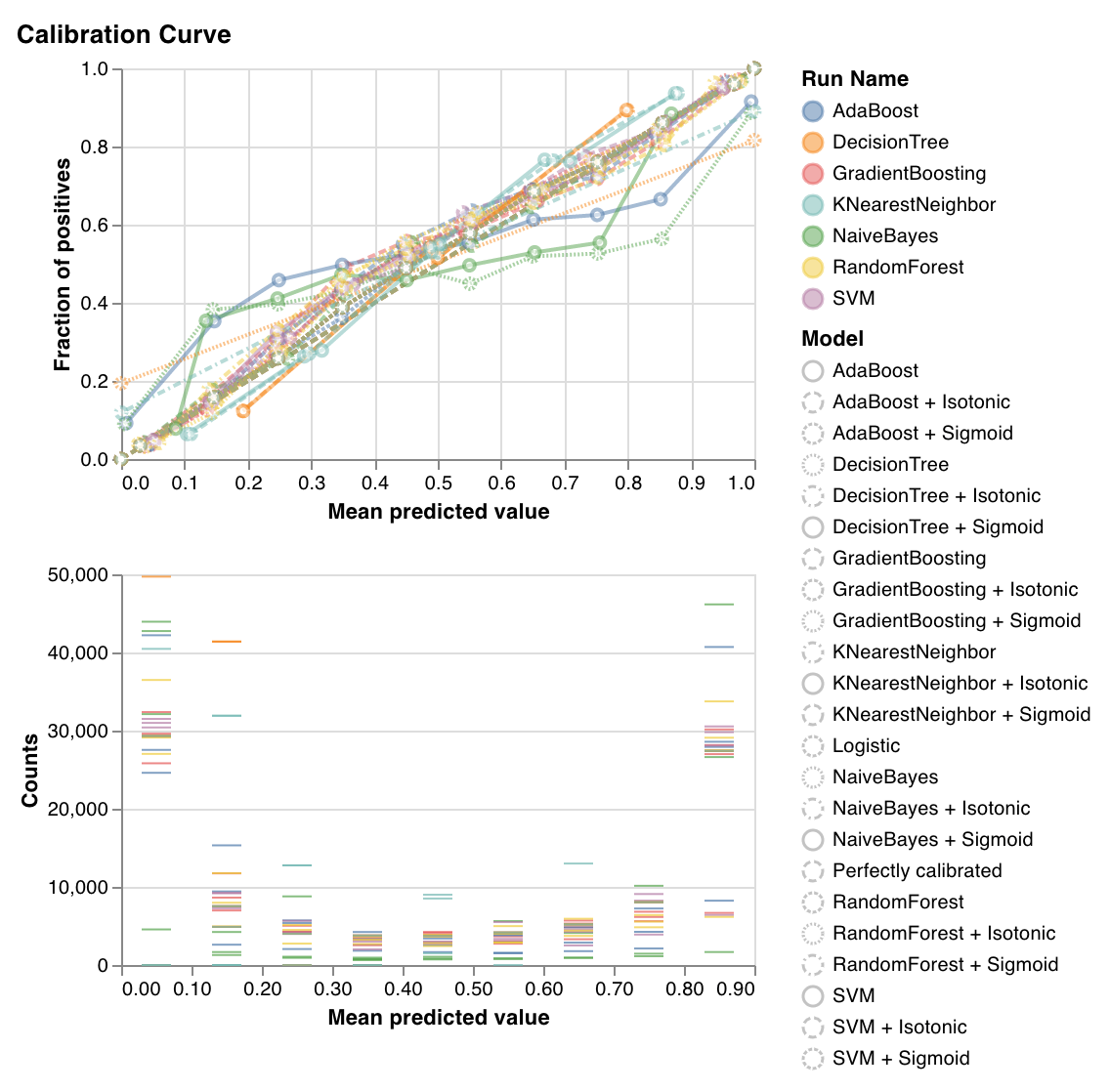

보정 곡선 (Calibration curve)

wandb.sklearn.plot_calibration_curve(clf, X, y, 'RandomForestClassifier')

- model (clf): 학습된 분류기를 인수로 받습니다.

- X (arr): 트레이닝 세트 피처.

- y (arr): 트레이닝 세트 라벨.

- model_name (str): 모델 이름. 기본값은 ‘Classifier’입니다.

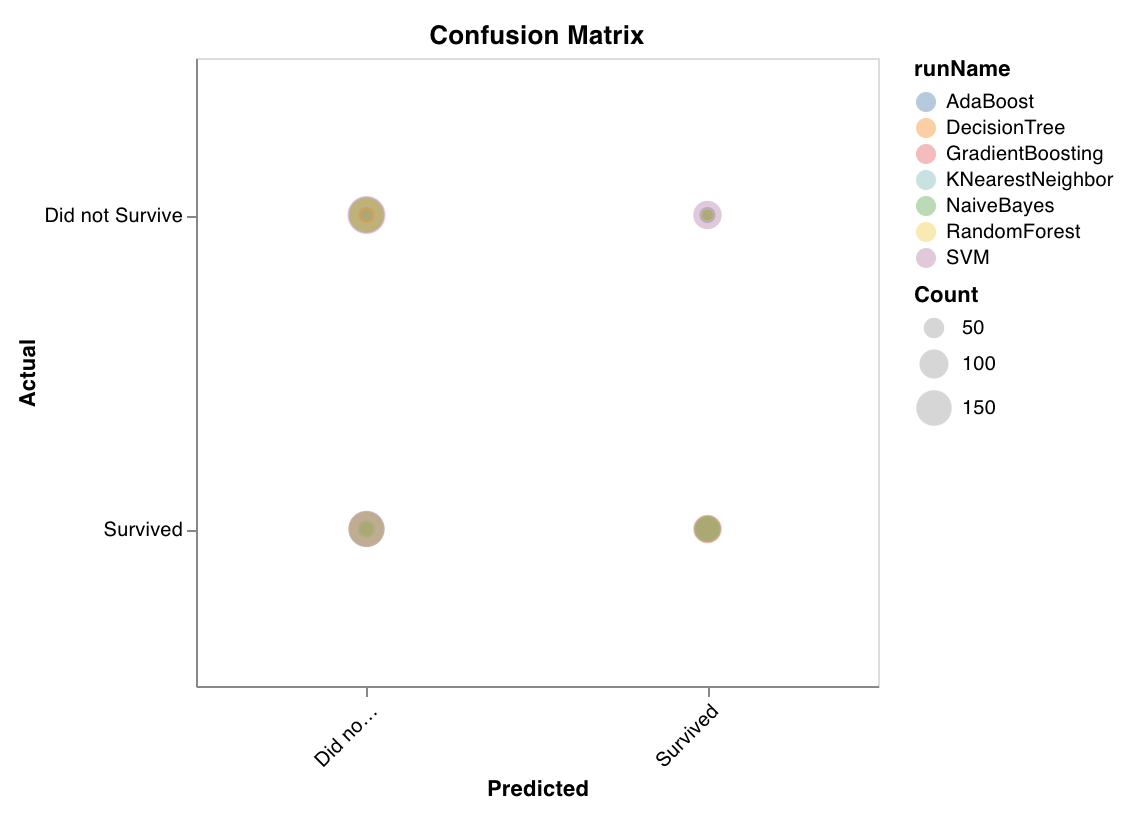

혼동 행렬 (Confusion matrix)

wandb.sklearn.plot_confusion_matrix(y_true, y_pred, labels)

- y_true (arr): 테스트 세트 라벨.

- y_pred (arr): 테스트 세트 예측 라벨.

- labels (list): 타겟 변수(y)의 이름이 지정된 라벨 목록.

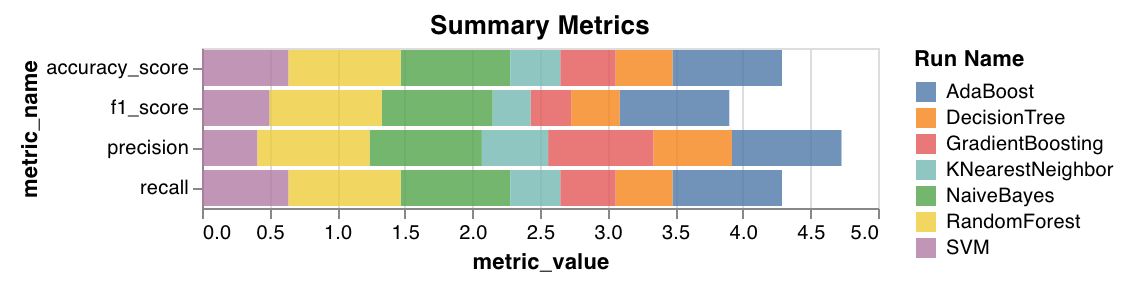

요약 메트릭 (Summary metrics)

- 분류를 위해

mse,mae,r2점수와 같은 요약 메트릭을 계산합니다. - 회귀를 위해

f1, 정확도, 정밀도, 재현율과 같은 요약 메트릭을 계산합니다.

wandb.sklearn.plot_summary_metrics(model, X_train, y_train, X_test, y_test)

- model (clf 또는 reg): 학습된 회귀 모델 또는 분류기를 인수로 받습니다.

- X (arr): 트레이닝 세트 피처.

- y (arr): 트레이닝 세트 라벨.

- X_test (arr): 테스트 세트 피처.

- y_test (arr): 테스트 세트 라벨.

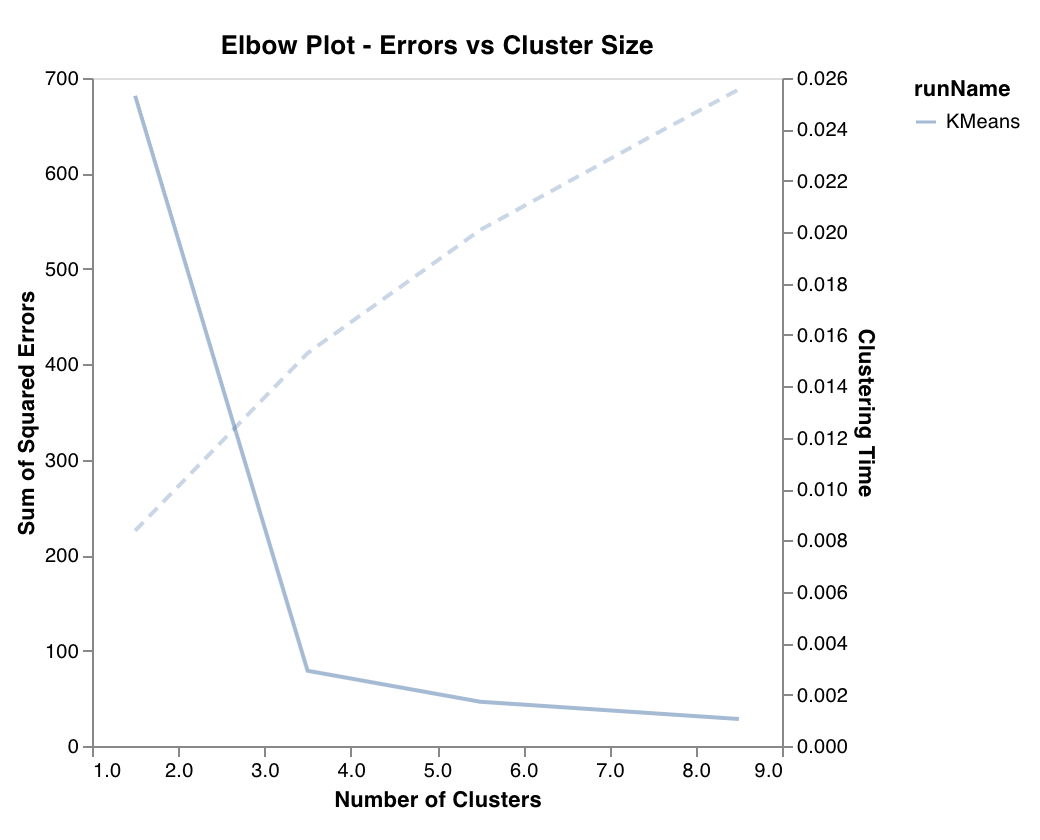

엘보우 차트 (Elbow plot)

wandb.sklearn.plot_elbow_curve(model, X_train)

- model (clusterer): 학습된 클러스터를 인수로 받습니다.

- X (arr): 트레이닝 세트 피처.

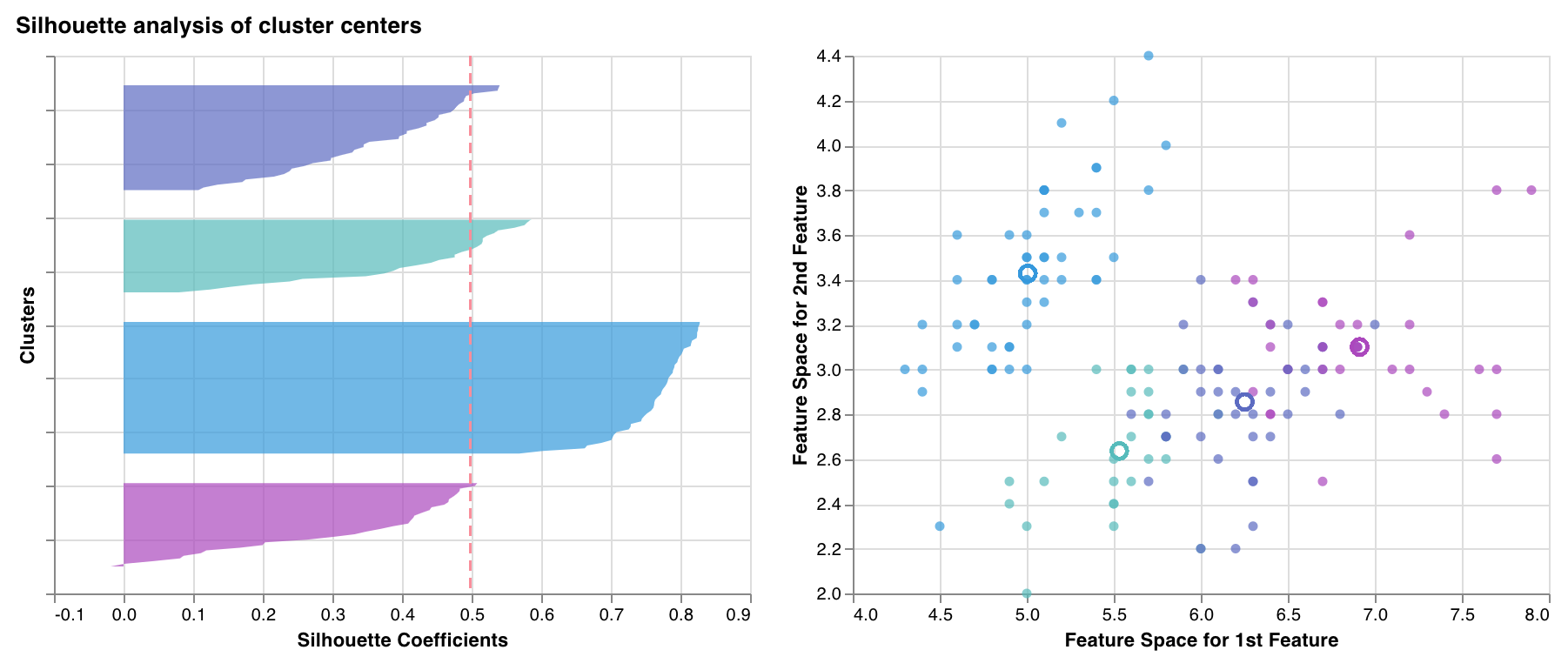

실루엣 차트 (Silhouette plot)

wandb.sklearn.plot_silhouette(model, X_train, ['spam', 'not spam'])

- model (clusterer): 학습된 클러스터를 인수로 받습니다.

- X (arr): 트레이닝 세트 피처.

- cluster_labels (list): 클러스터 라벨의 이름 목록. 클러스터 인덱스를 해당 이름으로 교체하여 차트를 더 읽기 쉽게 만듭니다.

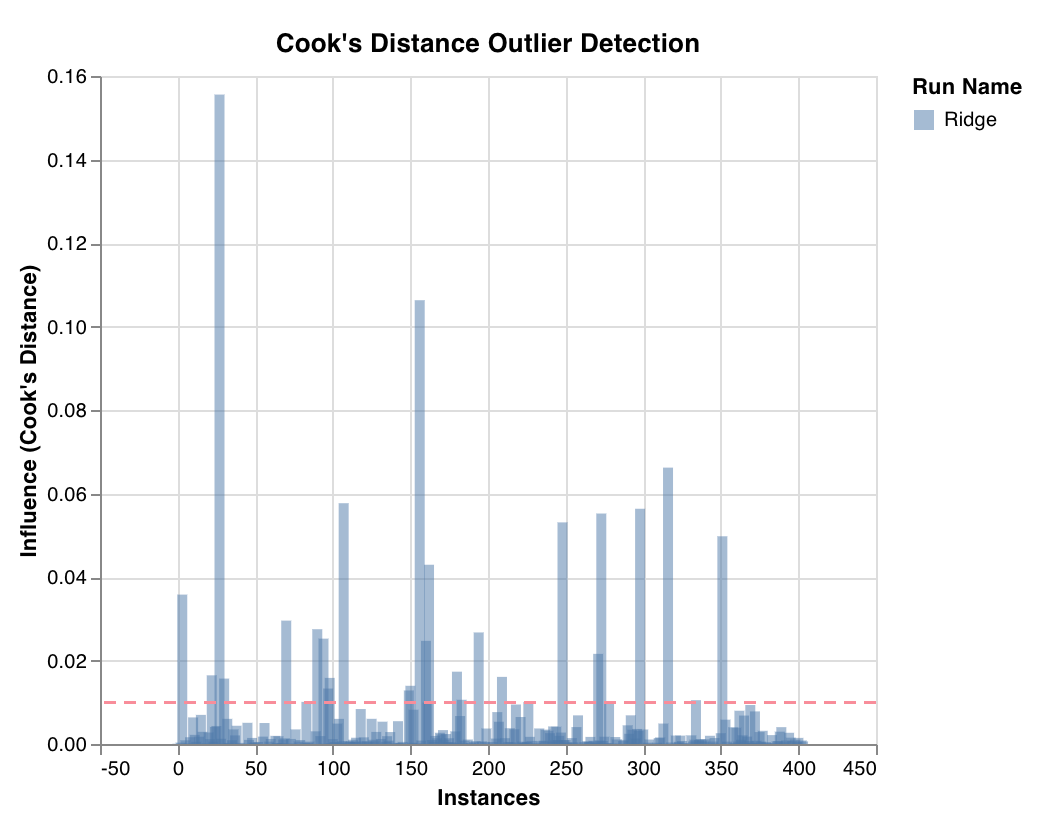

이상치 후보 차트 (Outlier candidates plot)

wandb.sklearn.plot_outlier_candidates(model, X, y)

- model (regressor): 학습된 분류기를 인수로 받습니다.

- X (arr): 트레이닝 세트 피처.

- y (arr): 트레이닝 세트 라벨.

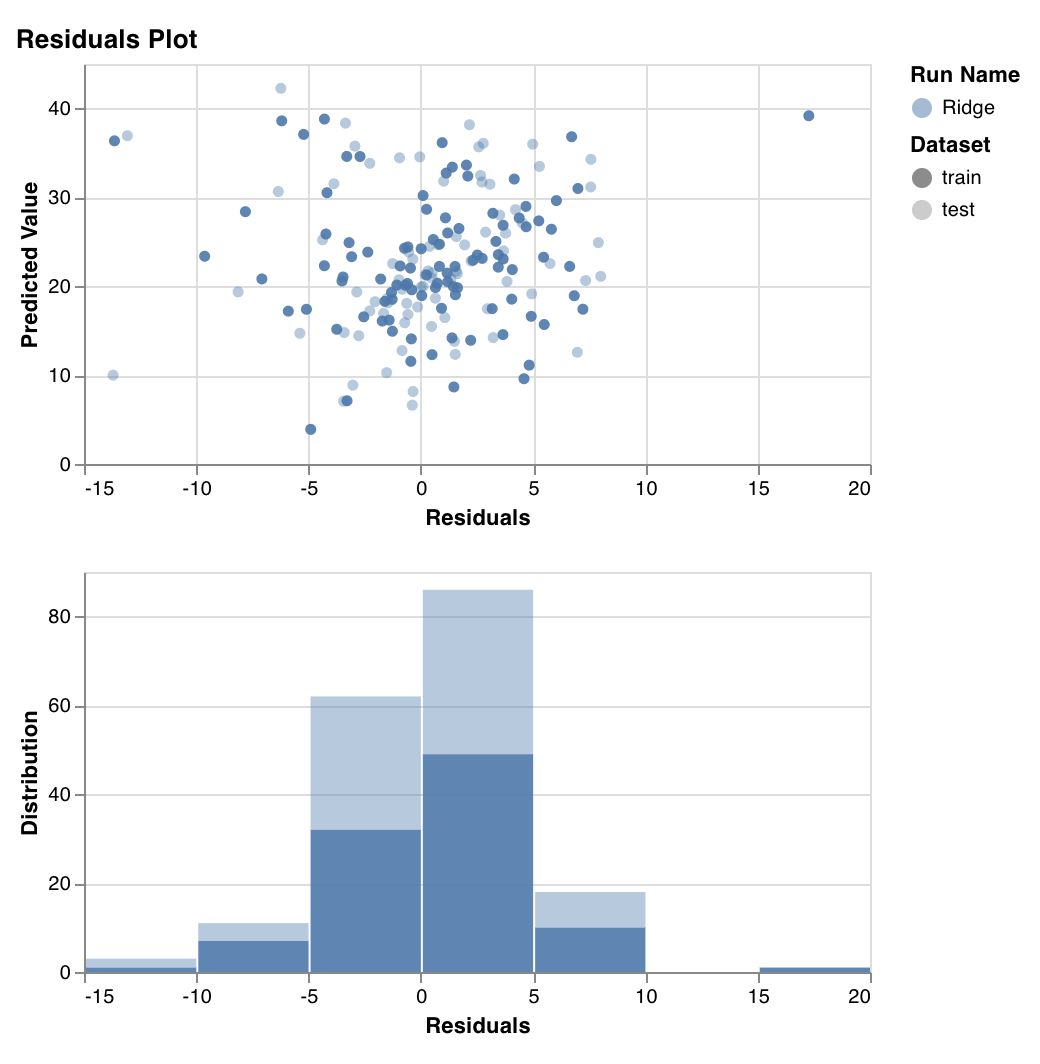

잔차 차트 (Residuals plot)

wandb.sklearn.plot_residuals(model, X, y)

- model (regressor): 학습된 분류기를 인수로 받습니다.

- X (arr): 트레이닝 세트 피처.

- y (arr): 트레이닝 세트 라벨. 질문이 있으시면 언제든지 Slack 커뮤니티에서 문의해 주세요.

예제

- Colab에서 실행: 시작하는 데 도움이 되는 간단한 노트북입니다.