LLM Evaluation Jobs is in Preview for W&B Multi-tenant Cloud. Compute is free during the preview period. Learn more

작동 방식

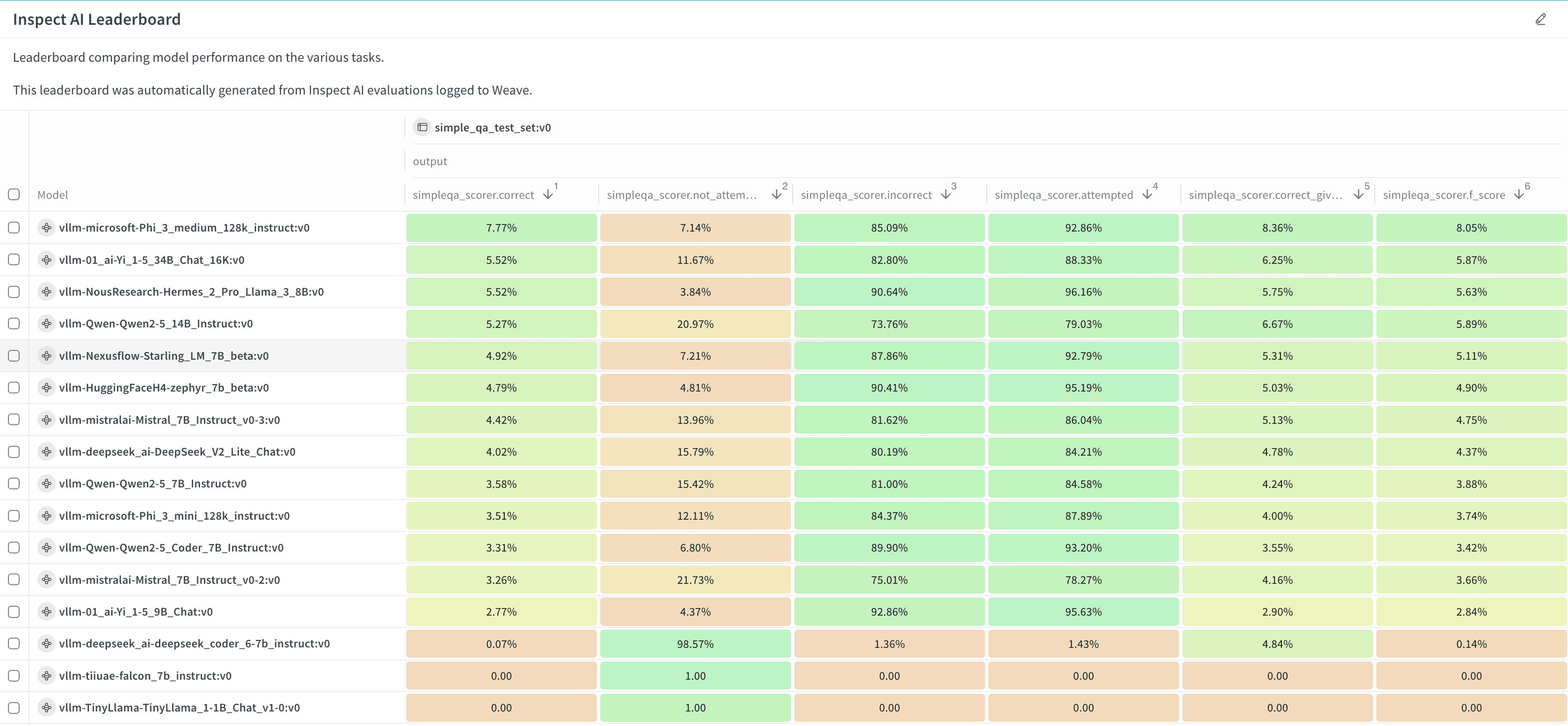

몇 단계만으로 모델 체크포인트 또는 공개적으로 엑세스 가능한 호스팅된 OpenAI 호환 모델을 평가하세요:- W&B Models 에서 평가 job을 설정합니다. 벤치마크 및 리더보드 생성 여부와 같은 설정을 정의합니다.

- 평가 job을 Launch 합니다.

- 결과와 리더보드를 확인하고 분석합니다.

다음 단계

상세 정보

가격 정책

LLM Evaluation Jobs 는 관리할 인프라 없이 완전히 관리되는 CoreWeave 컴퓨팅 환경에서 대중적인 벤치마크를 통해 모델 체크포인트 또는 호스팅된 API를 평가합니다. 유휴 시간이 아닌 실제 소비된 리소스에 대해서만 비용을 지불합니다. 가격은 컴퓨팅과 스토리지의 두 가지 구성 요소로 나뉩니다. 컴퓨팅은 퍼블릭 프리뷰 기간 동안 무료이며, 정식 출시 시 가격을 공지할 예정입니다. 저장된 결과에는 Models runs 에 저장된 메트릭 및 예시별 트레이스가 포함됩니다. 스토리지는 데이터 볼륨에 따라 매월 청구됩니다. 프리뷰 기간 동안 LLM Evaluation Jobs 는 Multi-tenant 클라우드에서만 사용할 수 있습니다. 자세한 내용은 Pricing 페이지를 참조하세요.Job 제한 사항

개별 평가 job에는 다음과 같은 제한 사항이 있습니다:- 평가할 모델의 최대 크기는 컨텍스트를 포함하여 86 GB입니다.

- 각 job은 GPU 2개로 제한됩니다.

요구 사항

- 모델 체크포인트를 평가하려면 모델 가중치가 VLLM 호환 아티팩트로 패키징되어야 합니다. 자세한 내용과 예시 코드는 예시: 모델 준비하기를 참조하세요.

- OpenAI 호환 모델을 평가하려면 해당 모델이 공개 URL에서 엑세스 가능해야 하며, 조직 또는 팀 관리자가 인증을 위한 API 키를 팀 시크릿(team secret)으로 설정해야 합니다.

- 특정 벤치마크는 점수 산정을 위해 OpenAI 모델을 사용합니다. 이러한 벤치마크를 실행하려면 조직 또는 팀 관리자가 필요한 API 키를 팀 시크릿으로 설정해야 합니다. 벤치마크에 이 요구 사항이 있는지 확인하려면 Evaluation benchmark catalog를 참조하세요.

- 특정 벤치마크는 Hugging Face의 gated 데이터셋에 대한 엑세스가 필요합니다. 이러한 벤치마크 중 하나를 실행하려면 조직 또는 팀 관리자가 Hugging Face에서 해당 gated 데이터셋에 대한 엑세스를 요청하고, Hugging Face 사용자 엑세스 토큰을 생성하여 팀 시크릿으로 설정해야 합니다. 벤치마크에 이 요구 사항이 있는지 확인하려면 Evaluation benchmark catalog를 참조하세요.