LLM Evaluation Jobs is in Preview for W&B Multi-tenant Cloud. Compute is free during the preview period. Learn more

사전 요구 사항

- LLM Evaluation Jobs 에 대한 요구 사항 및 제한 사항을 검토하세요.

- 특정 벤치마크를 실행하려면 팀 관리자가 필요한 API 키를 팀 범위의 secret으로 추가해야 합니다. 모든 팀 멤버는 평가 작업을 구성할 때 해당 secret을 지정할 수 있습니다.

- OpenAPI API 키: OpenAI 모델을 사용하여 점수를 매기는 벤치마크에서 사용됩니다. 벤치마크를 선택한 후 Scorer API key 필드가 나타나면 필수입니다. secret 이름은

OPENAI_API_KEY여야 합니다. - Hugging Face 사용자 액세스 토큰: 하나 이상의 gated Hugging Face 데이터셋에 대한 액세스가 필요한

lingoly및lingoly2와 같은 특정 벤치마크에 필요합니다. 벤치마크 선택 후 Hugging Face Token 필드가 나타나면 필수입니다. API 키는 해당 데이터셋에 대한 액세스 권한이 있어야 합니다. 사용자 액세스 토큰 및 gated 데이터셋 액세스에 대한 Hugging Face 문서를 참조하세요. - W&B Inference에서 제공하는 모델을 평가하려면 조직 또는 팀 관리자가 임의의 값을 가진

WANDB_API_KEY를 생성해야 합니다. 이 secret은 실제로 인증에 사용되지는 않습니다.

- OpenAPI API 키: OpenAI 모델을 사용하여 점수를 매기는 벤치마크에서 사용됩니다. 벤치마크를 선택한 후 Scorer API key 필드가 나타나면 필수입니다. secret 이름은

- 평가할 모델은 공개적으로 액세스 가능한 URL에서 사용할 수 있어야 합니다. 조직 또는 팀 관리자는 인증을 위한 API 키가 포함된 팀 범위의 secret을 생성해야 합니다.

- 평가 결과를 저장할 새로운 W&B 프로젝트를 생성합니다. 왼쪽 탐색 창에서 Create new project를 클릭합니다.

- 특정 벤치마크에 대한 문서를 검토하여 작동 방식을 이해하고 특정 요구 사항을 파악하세요. 편의를 위해 사용 가능한 평가 벤치마크 레퍼런스에 관련 링크가 포함되어 있습니다.

모델 평가하기

다음 단계에 따라 평가 작업을 설정하고 런칭하세요.- W&B 에 로그인한 다음 왼쪽 탐색 창에서 Launch를 클릭합니다. LLM Evaluation Jobs 페이지가 표시됩니다.

- Evaluate hosted API model을 클릭하여 평가를 설정합니다.

- 평가 결과를 저장할 대상 Projects 를 선택합니다.

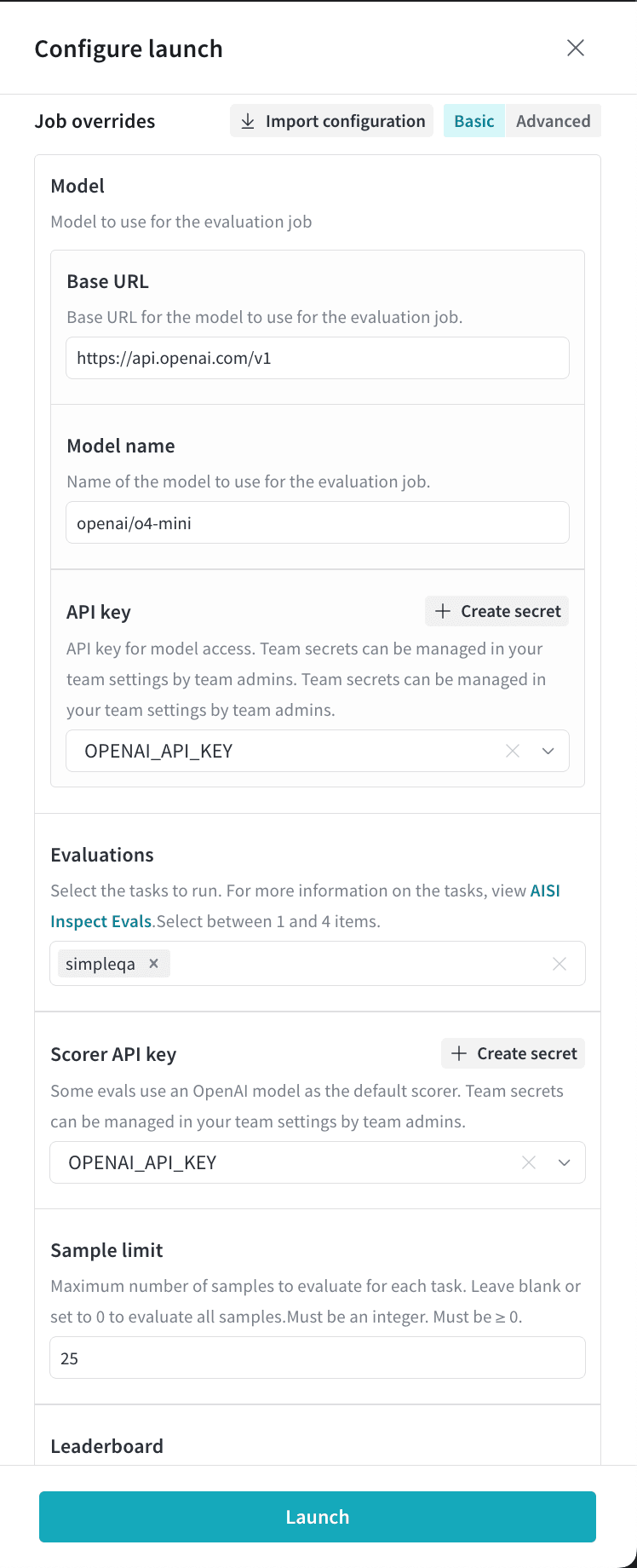

- Model 섹션에서 평가할 베이스 URL과 모델 이름을 지정하고, 인증에 사용할 API 키를 선택합니다. 모델 이름은 AI Security Institute에서 정의한 OpenAI 호환 형식으로 제공하세요. 예를 들어, OpenAI 모델은

openai/<model-name>과 같은 구문으로 지정합니다. 호스팅된 모델 제공업체 및 모델의 전체 목록은 AI Security Institute의 모델 제공업체 레퍼런스를 참조하세요.- W&B Inference에서 제공하는 모델을 평가하려면 베이스 URL을

https://api.inference.wandb.ai/v1로 설정하고 모델 이름을openai-api/wandb/<model_id>구문으로 지정하세요. 자세한 내용은 Inference 모델 카탈로그를 참조하세요. - OpenRouter 제공업체를 사용하려면 모델 이름 앞에

openrouter를 붙여openrouter/<model-name>구문을 사용하세요. - 커스텀 OpenAPI 호환 모델을 평가하려면 모델 이름을

openai-api/wandb/<model-name>구문으로 지정하세요.

- W&B Inference에서 제공하는 모델을 평가하려면 베이스 URL을

- Select evaluations를 클릭한 다음 실행할 벤치마크를 최대 4개까지 선택합니다.

- 점수 산정에 OpenAI 모델을 사용하는 벤치마크를 선택하면 Scorer API key 필드가 표시됩니다. 해당 필드를 클릭한 다음

OPENAI_API_KEYsecret을 선택합니다. 편의를 위해 팀 관리자는 이 드로어에서 Create secret을 클릭하여 secret을 바로 생성할 수 있습니다. - Hugging Face의 gated 데이터셋에 대한 액세스가 필요한 벤치마크를 선택하면 Hugging Face token 필드가 표시됩니다. 해당 데이터셋에 대한 액세스를 요청한 다음, Hugging Face 사용자 액세스 토큰이 포함된 secret을 선택합니다.

- 선택 사항으로, Sample limit을 양의 정수로 설정하여 평가할 벤치마크 샘플의 최대 개수를 제한할 수 있습니다. 설정하지 않으면 태스크의 모든 샘플이 포함됩니다.

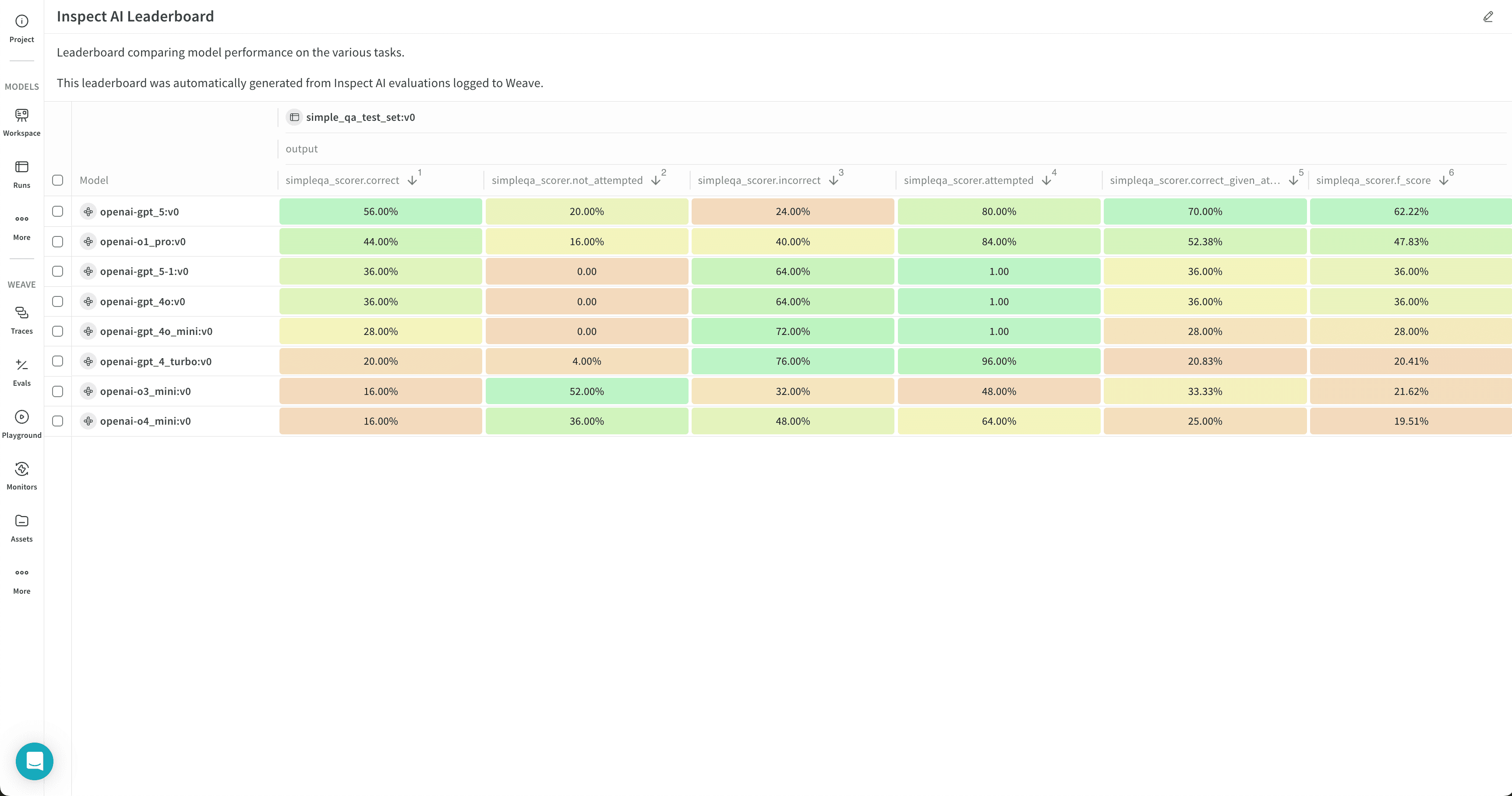

- 리더보드를 자동으로 생성하려면 Publish results to leaderboard를 클릭합니다. 리더보드는 모든 평가를 Workspace 패널에 한데 모아 표시하며, Reports 에서 공유할 수도 있습니다.

- Launch를 클릭하여 평가 작업을 런칭합니다.

- 페이지 상단의 원형 화살표 아이콘을 클릭하여 최근 run 모달을 엽니다. 평가 작업은 다른 최근 Runs 와 함께 표시됩니다. 완료된 run 의 이름을 클릭하여 단일 run 뷰에서 열거나, Leaderboard 링크를 클릭하여 리더보드를 직접 엽니다. 자세한 내용은 결과 보기를 참조하세요.

o4-mini에 대해 simpleqa 벤치마크를 실행합니다.

Review evaluation results

Review your evaluation job results in W&B Models in the destination project’s workspace.- Click the circular arrow icon at the top of the page to open the recent run modal, where evaluation jobs appear with other runs in the project. If the evaluation job has a leaderboard, click Leaderboard to open the leaderboard in full screen, or click a run name to open it in the project in single-run view.

- View the evaluation job’s traces in the Evaluations section of a workspace or in the Traces tab of the Weave sidebar panel.

- Click the Overview tab to view detailed information about the evaluation job, including its configuration and summary metrics.

- Click the Logs tab to view, search, or download the evaluation job’s debug logs.

- Click the Files tab to browse, view, or download the evaluation job’s files, including code, log, configuration, and other output files.

Customize a leaderboard

The leaderboard shows results for all evaluation jobs sent to a given project, with one row per benchmark per evaluation job. Columns display details like the trace, input values, and output values for the evaluation job. For more information about leaderboards, see Leaderboards in Weave.- By default, all evaluation jobs are displayed. Filter or search for an evaluation job using the run selector at the left.

- By default, evaluation jobs are ungrouped. To group by one or more columns, click the Group icon. You can show or hide a group, or expand a group to view its runs.

- By default, all operations are displayed. To display only a single operation, click All ops and select an operation.

- To sort by a column, click the column heading. To customize the display of columns, click Columns.

- By default, headers are organized in a single level. You can increase the header depth to organize related headers together.

- Select or deselect individual columns to show or hide them, or show or hide all columns with a click.

- Pin columns to display them before unpinned columns.

Export a leaderboard

To export a leaderboard:- Click the download icon, located near the Columns button.

- To optimize the export size, only the trace roots are exported by default. To export full traces, turn off Trace roots only.

- To optimize the export size, feedback and costs are not exported by default. To include them in the export, toggle Feedback or Costs.

- By default, the export is in JSONL format. To customize the format, click Export to file and select a format.

- To export the leaderboard in your browser, click Export.

- To export the leaderboard programmatically, select Python or cURL, then click Copy and run the script or command.

Re-run an evaluation job

Depending on your situation, there are multiple ways to re-run an evaluation job or view its configuration.- To re-run the last evaluation job again, follow the steps in Evaluate your model. Select the destination project, then the model artifact details and the selected benchmarks you selected last time are populated automatically. Optionally, make adjustments, then launch the evaluation job.

- To re-run an evaluation job from the project’s Runs tab or run selector, hover over the run name and click the play icon. The job configuration drawer displays with the settings pre-populated. Optionally adjust the settings, then click Launch.

- To re-run an evaluation job from a different project, import its configuration:

- Follow the steps in Evaluate your model. After you select the destination project, click Import configuration.

- Select the project that contains the evaluation job to import, then select the evaluation job run. The job configuration drawer displays with the settings pre-populated.

- Optionally adjust the configuration.

- Click Launch.

Export an evaluation job configuration

Export an evaluation job’s configuration from the run’s Files tab.- Open the run in single-run view.

- Click the Files tab.

- Click the download button next to

config.yamlto download it locally.