weave.op를 사용하여 Bedrock 모델에 대한 모든 호출을 추적하기 위한 재사용 가능한 오퍼레이션을 생성할 수 있습니다. 또한 Anthropic 모델을 사용하는 경우, Anthropic을 위한 Weave 의 내장 인테그레이션을 선택적으로 사용할 수 있습니다.

Traces

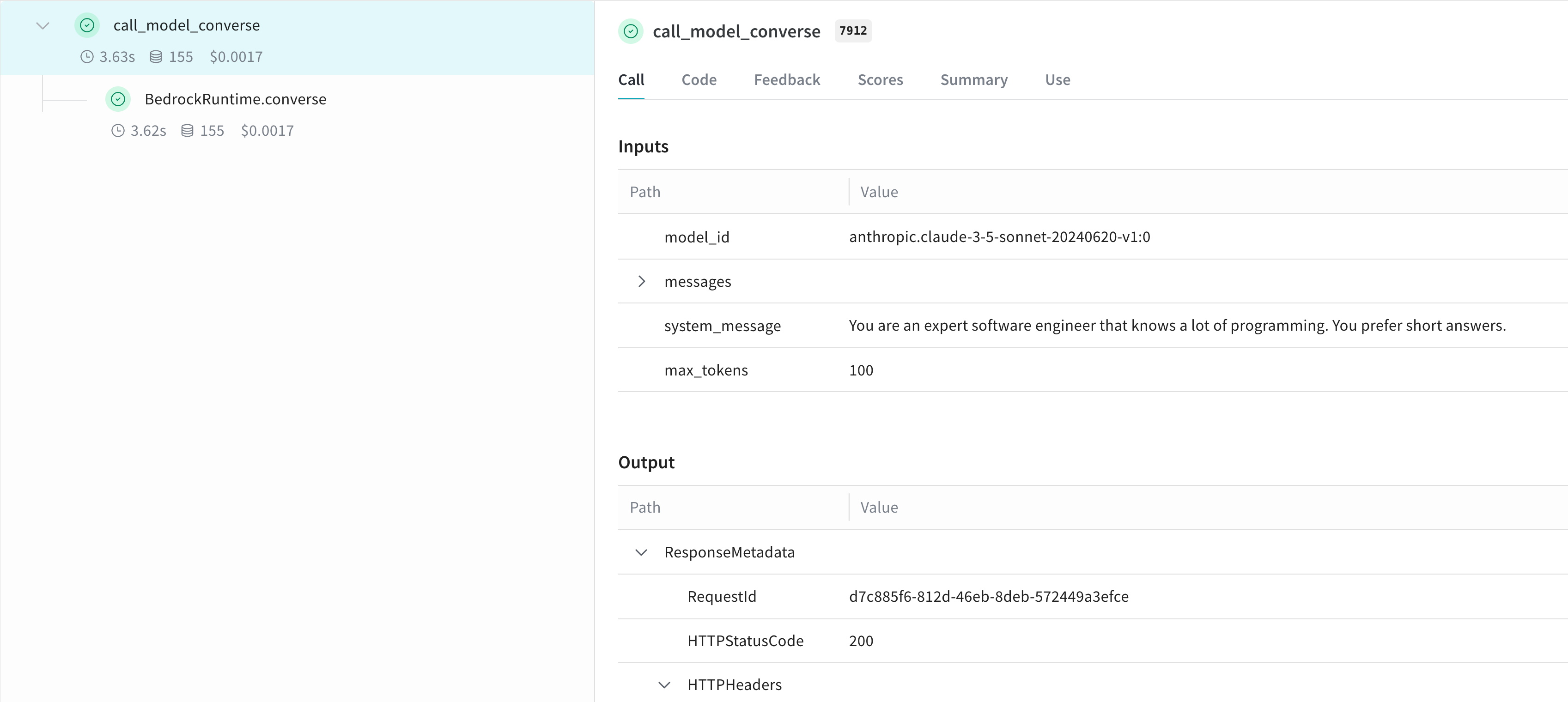

Weave 는 Bedrock API 호출에 대한 trace를 자동으로 캡처합니다. Weave 를 초기화하고 클라이언트를 패치한 후 평소와 같이 Bedrock 클라이언트를 사용할 수 있습니다.converse API를 사용하는 방법은 다음과 같습니다:

사용자 정의 op로 래핑하기

@weave.op() 데코레이터를 사용하여 재사용 가능한 오퍼레이션을 생성할 수 있습니다. 다음은 invoke_model과 converse API를 모두 사용하는 예시입니다:

더 쉬운 실험을 위한 Model 생성

실험을 더 잘 정리하고 파라미터를 캡처하기 위해 Weave Model 을 생성할 수 있습니다. 다음은 converse API를 사용하는 예시입니다: