Traces

LLM 호출을 추적하는 것은 디버깅과 성능 모니터링에 매우 중요합니다. Weave는 Cerebras Cloud SDK의 Traces를 자동으로 캡처하여 이를 돕습니다. Cerebras와 함께 Weave를 사용하는 예시는 다음과 같습니다:

고유한 ops로 래핑하기

Weave ops는 실험의 재현성(reproducibility)과 추적 가능성을 향상시키는 강력한 방법을 제공합니다. 코드를 자동으로 버전 관리하고 입력 및 출력을 캡처함으로써 이를 수행합니다. Cerebras SDK와 함께 Weave ops를 활용하는 예시는 다음과 같습니다:더 쉬운 실험을 위한 Model 생성

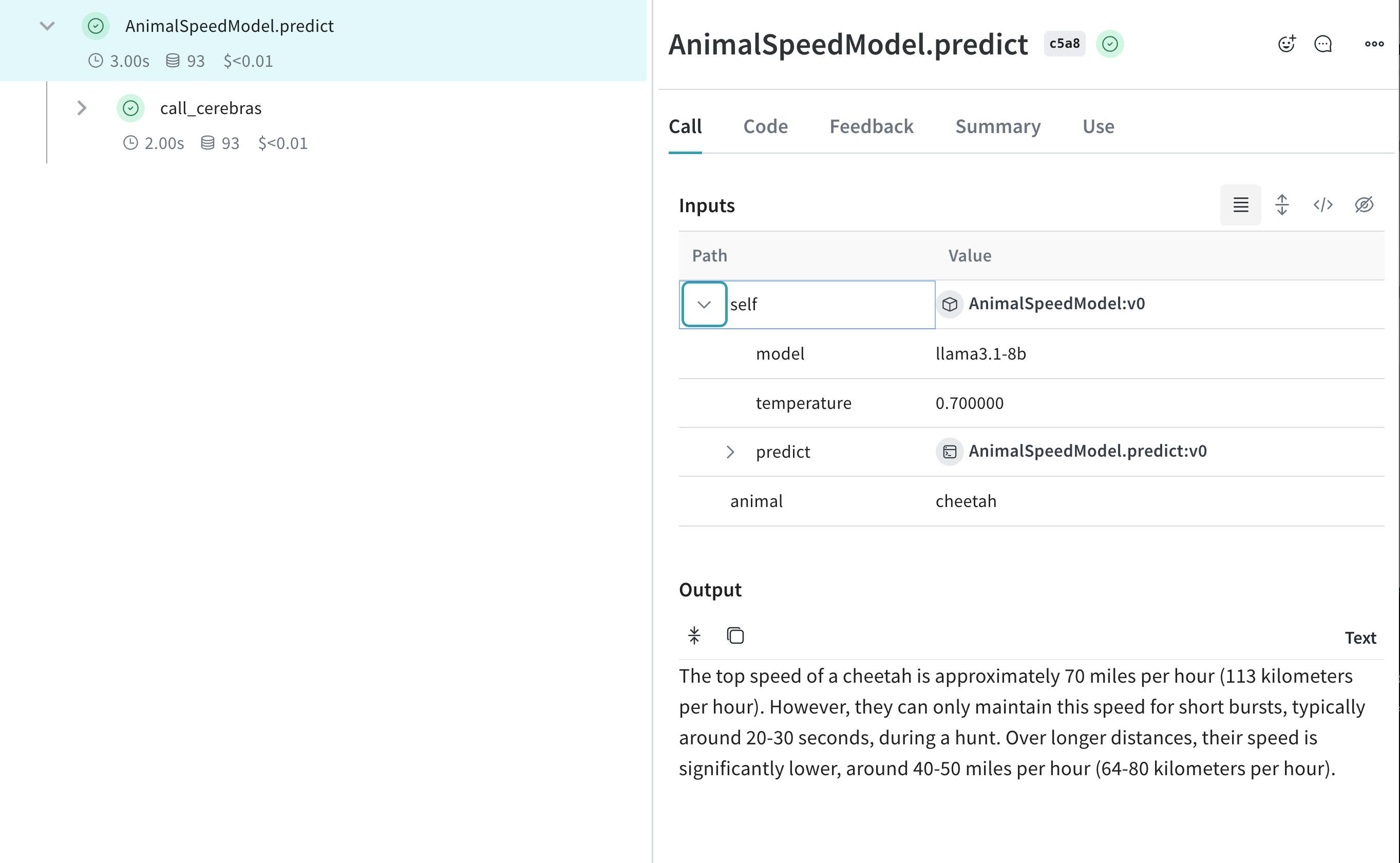

Weave의 Model 클래스는 앱의 서로 다른 반복 버전을 정리하고 비교하는 데 도움을 줍니다. 이는 Cerebras 모델로 실험할 때 특히 유용합니다. 다음은 예시입니다: