시작하기

시작하려면 스크립트 시작 부분에서weave.init()을 호출하기만 하면 됩니다. weave.init()의 인수는 트레이스를 체계적으로 관리하는 데 도움이 되는 프로젝트 이름입니다.

트레이싱 (Tracing)

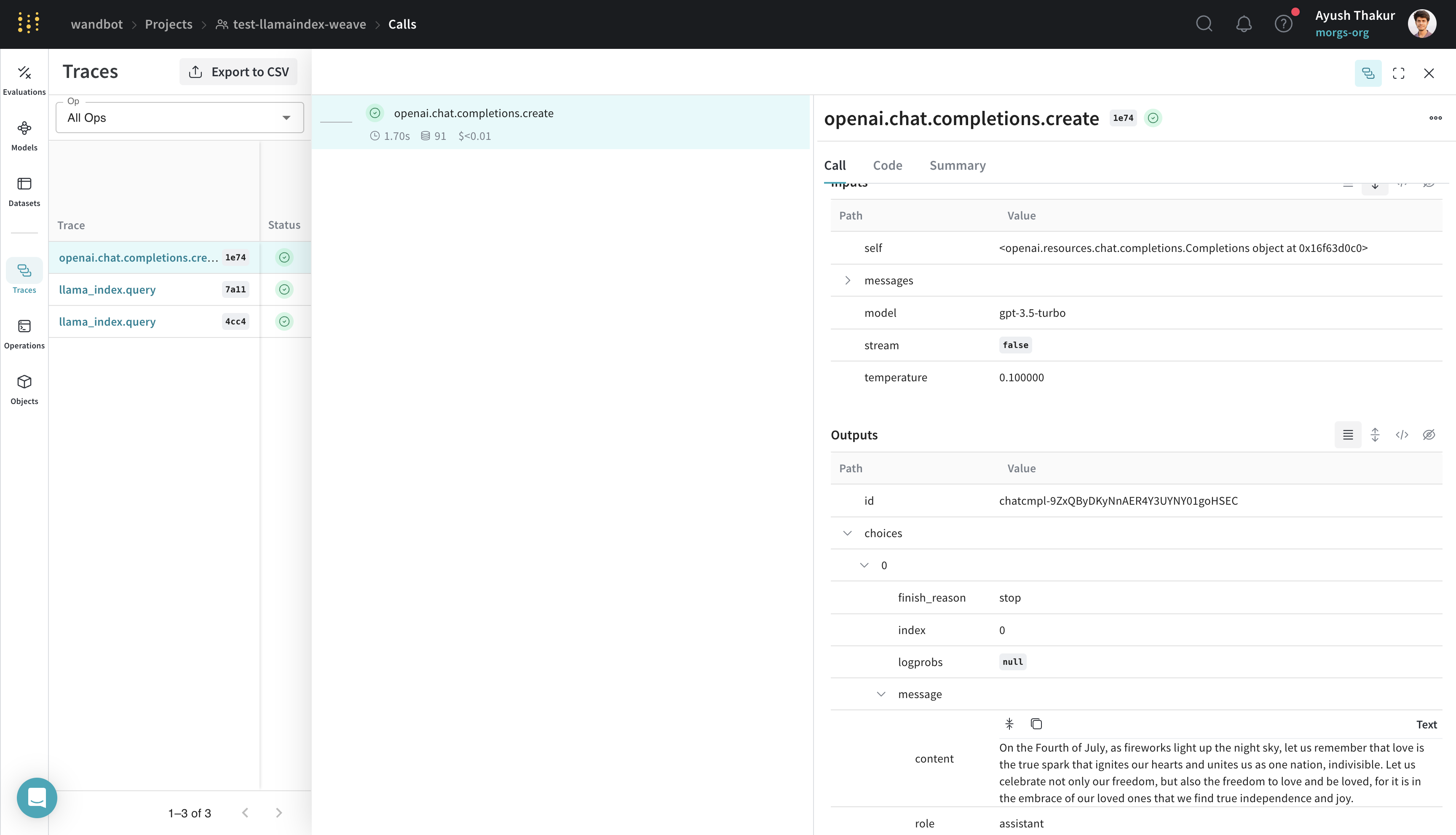

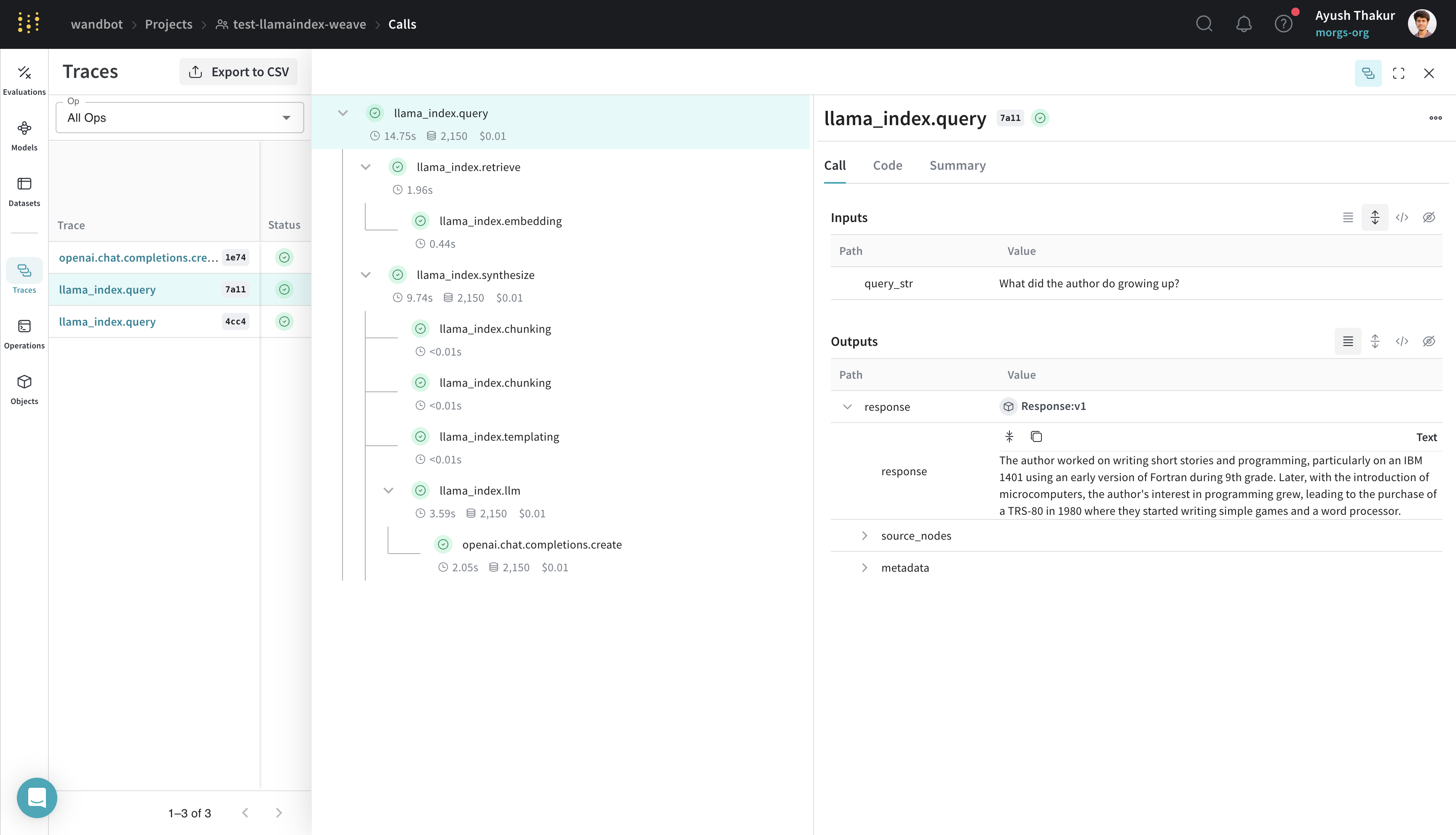

LlamaIndex 는 데이터와 LLM 을 쉽게 연결해 주는 것으로 잘 알려져 있습니다. 간단한 RAG 애플리케이션에는 임베딩 단계, 리트리벌(retrieval) 단계, 그리고 응답 합성 단계가 필요합니다. 복잡성이 증가함에 따라, 개발 및 프로덕션 단계 모두에서 개별 단계의 트레이스를 중앙 데이터베이스에 저장하는 것이 중요해집니다. 이러한 트레이스는 애플리케이션을 디버깅하고 개선하는 데 필수적입니다. Weave 는 프롬프트 템플릿, LLM 호출, 툴, 에이전트 단계를 포함하여 LlamaIndex 라이브러리를 통해 이루어지는 모든 호출을 자동으로 추적합니다. Weave 웹 인터페이스에서 트레이스를 확인할 수 있습니다. 다음은 LlamaIndex 의 시작 튜토리얼 (OpenAI)에 나오는 간단한 RAG 파이프라인의 예시입니다.

원클릭 가시성 (One-click observability) 🔭

LlamaIndex 는 프로덕션 환경에서 원칙 있는 LLM 애플리케이션을 구축할 수 있도록 원클릭 가시성 🔭 기능을 제공합니다. W&B 의 인테그레이션은 LlamaIndex 의 이 기능을 활용하여WeaveCallbackHandler()를 llama_index.core.global_handler에 자동으로 설정합니다. 따라서 LlamaIndex 와 Weave 사용자로서 해야 할 일은 weave.init(<name-of-project>)를 통해 Weave run 을 초기화하는 것뿐입니다.

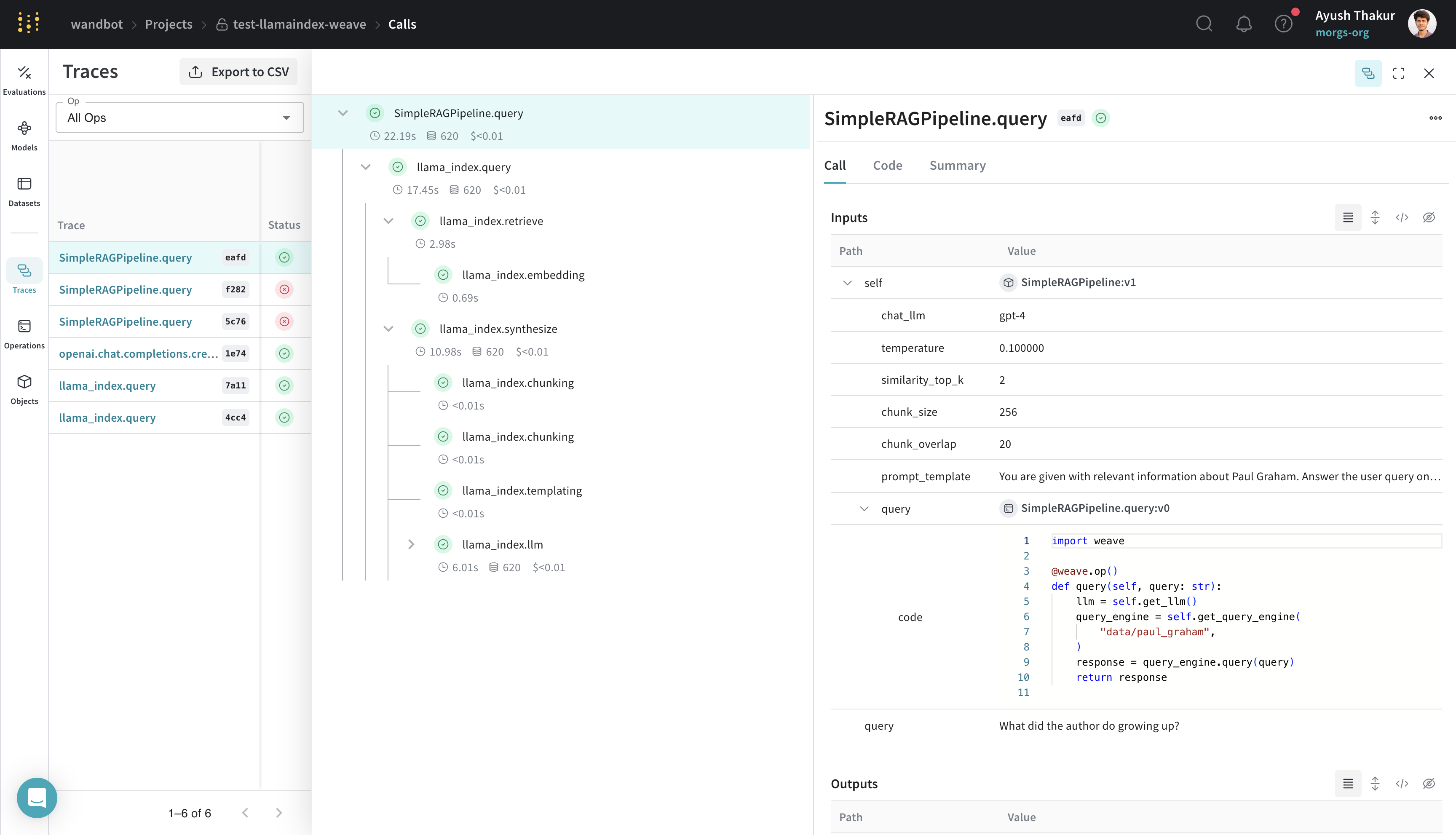

더 쉬운 실험을 위한 Model 생성

다양한 유스 케이스를 위한 애플리케이션에서 프롬프트, 모델 설정, 추론 파라미터와 같은 여러 구성 요소가 섞여 있는 LLM 을 체계화하고 평가하는 것은 어려운 일입니다. weave.Model을 사용하면 시스템 프롬프트나 사용하는 모델과 같은 실험적인 세부 사항을 캡처하고 체계화하여 서로 다른 반복 회차(iteration)를 더 쉽게 비교할 수 있습니다.

다음 예시는 weave/data 폴더에 있는 데이터를 사용하여 WeaveModel 내에서 LlamaIndex 쿼리 엔진을 구축하는 방법을 보여줍니다.

weave.Model을 상속받은 이 SimpleRAGPipeline 클래스는 이 RAG 파이프라인의 중요한 파라미터들을 체계적으로 관리합니다. predict 메소드에 @weave.op() 데코레이터를 추가하면 트레이싱이 가능해집니다.

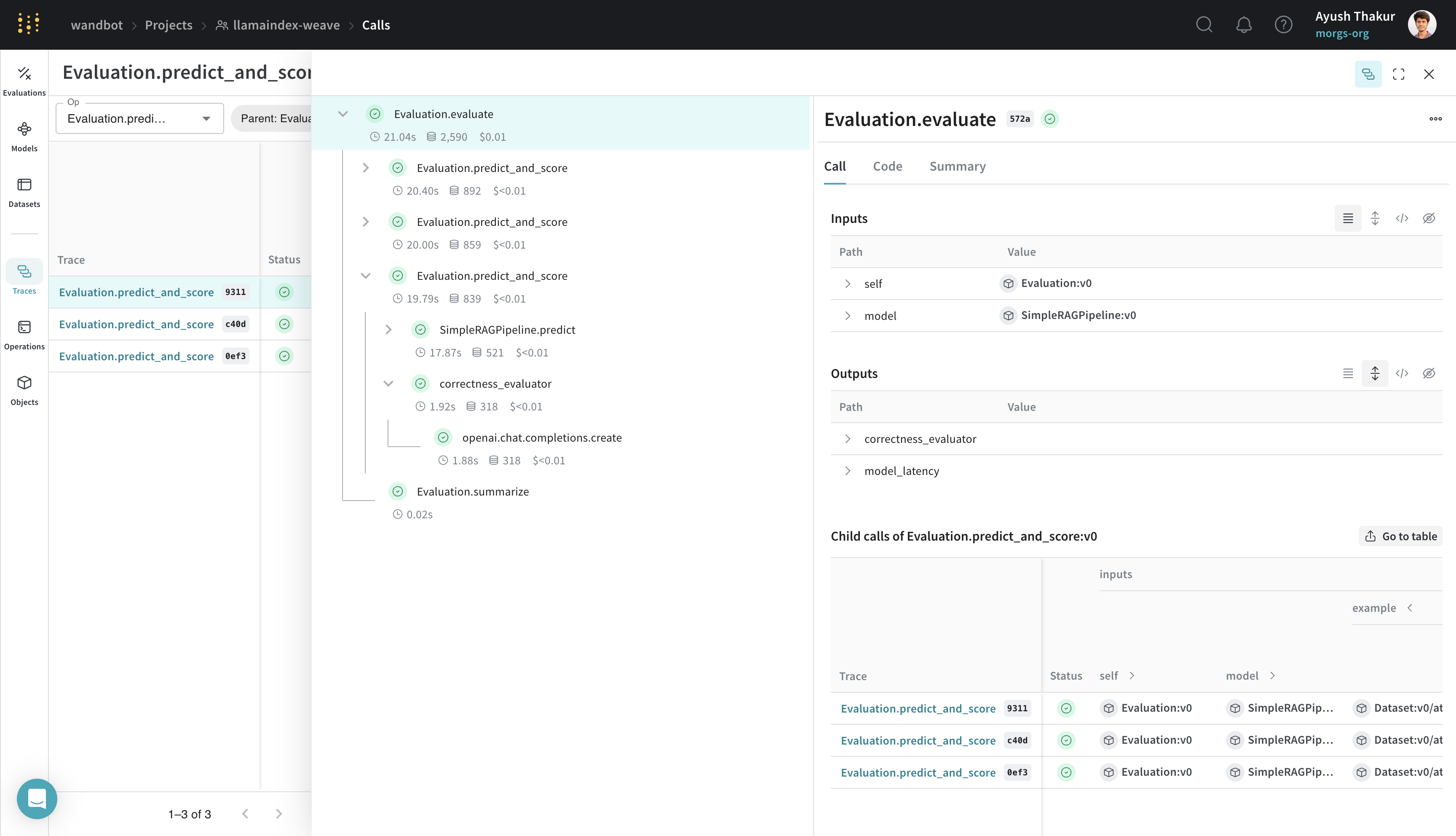

weave.Evaluation으로 평가 수행하기

평가(Evaluation)는 애플리케이션의 성능을 측정하는 데 도움을 줍니다. weave.Evaluation 클래스를 사용하면 모델이 특정 태스크나 Datasets 에서 얼마나 잘 수행되는지 캡처할 수 있어, 서로 다른 모델과 애플리케이션의 반복 회차를 더 쉽게 비교할 수 있습니다. 다음 예시는 우리가 만든 모델을 평가하는 방법을 보여줍니다.

weave.Evaluation을 사용하여 평가하려면 평가용 데이터셋, 스코어러(scorer) 함수 및 weave.Model이 필요합니다. 세 가지 주요 구성 요소에 대한 몇 가지 참고 사항은 다음과 같습니다:

- 평가 샘플 딕셔너리의 키가 스코어러 함수의 인수 및

weave.Model의predict메소드 인수와 일치하는지 확인하세요. weave.Model은predict,infer또는forward라는 이름의 메소드를 가져야 합니다. 트레이싱을 위해 이 메소드에@weave.op()를 데코레이션하세요.- 스코어러 함수는

@weave.op()로 데코레이션되어야 하며output을 이름이 지정된 인수(named argument)로 가져야 합니다.

Weave 를 LlamaIndex 와 통합함으로써, LLM 애플리케이션에 대한 포괄적인 로깅 및 모니터링을 보장하고, 평가를 통해 더 쉬운 디버깅과 성능 최적화를 진행할 수 있습니다.

Weave 를 LlamaIndex 와 통합함으로써, LLM 애플리케이션에 대한 포괄적인 로깅 및 모니터링을 보장하고, 평가를 통해 더 쉬운 디버깅과 성능 최적화를 진행할 수 있습니다.